Cảm biến camera trên những chiếc smartphone của ngày nay thực sự là những thành tựu khổng lồ. Qua hàng thập kỷ, những sáng tạo được Sony, Samsung, OmniVision và nhiều công ty khác mang đến đã giúp tạo ra những chiếc cảm biến nhỏ hơn cả móng tay nhưng vẫn đủ nhạy sáng để phục vụ tốt cho hàng triệu người. Những ai đã từng lớn lên với những chiếc máy ảnh số cồng kềnh với chất lượng dở tệ của thập niên 90 sẽ không khỏi ngỡ ngàng về tiềm năng của cảm biến smartphone ngày nay.

Đáng tiếc rằng, vì cảm biến cũng là chip silicon, chúng cũng có giới hạn. Nếu như các con chip Intel hay Qualcomm mới chỉ đang đi gần đến điểm kết của Định luật Moore, cảm biến camera trên smartphone đã đi đến giới hạn vật lý từ rất lâu rồi.

Tín đồ nhiếp ảnh chắc hẳn đã quen với phép so sánh cảm biến hứng ánh sáng như những chiếc xô hứng nước, nhưng điều mà họ không ít khi nghĩ đến là không gian nhỏ hẹp bên trong từng chiếc điện thoại mỏng nhẹ.

Bạn có thể đặt một chiếc xô lớn. Bạn có thể đặt nhiều xô nhỏ. Bạn có thể làm xô hình tròn, hình vuông. Bạn có thể hứng nước lâu hơn Nhưng đến cuối cùng, nước mưa rơi xuống cũng chỉ có vậy, diện tích đặt xô cũng chỉ có vậy. Dù có cố sắp xếp đến thế nào, bạn cũng không thể vượt qua giới hạn vật lý của smartphone.

Sẽ là không đúng nếu khẳng định rằng Sony hay Samsung không thể tiếp tục cải tiến cảm biến trên những chiếc smartphone. Thế nhưng, một lần nữa, những gì mà các ông lớn này mang lại vẫn là quá nhỏ để thuyết phục người dùng. Liệu những khẳng định như "chúng tôi đã chuyển từ cảm biến 1/3.2 lên cảm biến 1/3" có thuyết phục được hàng triệu người dùng bỏ tiền ra nâng cấp smartphone mỗi năm?

Chưa kể, thị trường cảm biến smartphone còn bị Sony thống trị. Mỗi model cảm biến được Sony hay Samsung ra mắt đều sẽ được chia sẻ bởi nhiều nhà sản xuất khác nhau. Cũng giống như việc các nhà sản xuất không hề nhắc đến thế mạnh của Android khi vén màn phần cứng mới, sẽ chẳng có nhà sản xuất nào mang cảm biến ra đọ với đối thủ cả.

Hãy làm một phép so sánh nho nhỏ: cảm biến APS-C khá phổ biến trên DSLR có có kích cỡ 23x15mm, tức là 345mm2. Diện tích của cảm biến trên iPhone XS chỉ là 40.6mm2, tức là không bằng 1/8 APS-C. Bất kỳ một chiếc smartphone nào khác cũng vậy: lượng ánh sáng chúng thu về chỉ bằng một phần quá nhỏ so với máy ảnh chuyên dụng.

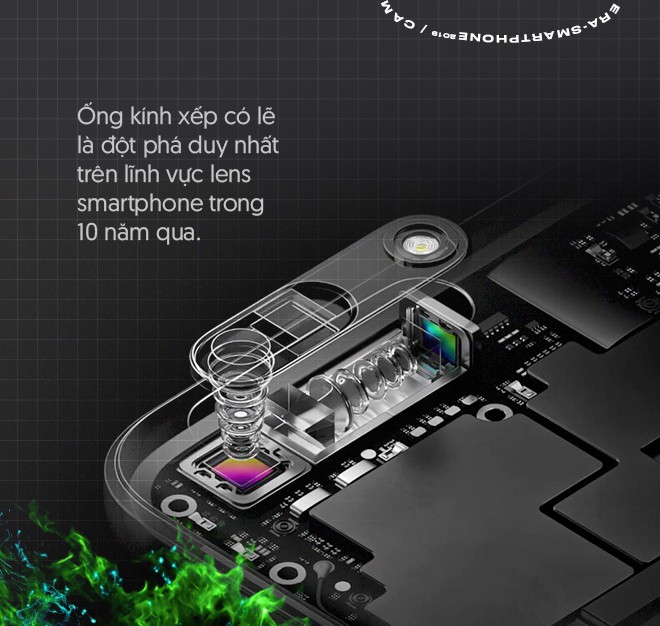

Cửa trập thì rõ ràng là không thể cải thiện. Liệu các nhà sản xuất có thể cải thiện ống kính trên smartphone?

Thực tế là có. Mới đây OPPO và Huawei đã tiên phong sử dụng cơ chế ảnh ống kính xếp (folded optics) để đem đến khả năng zoom vật lý khoảng 10X.

Nhưng đó là thay đổi đầu tiên trong vòng 12 năm của ống kính trên smartphone. Cũng như cảm biến, không gian để cải thiện cơ chế lens bên trong điện thoại vẫn là quá hạn hẹp. Mục đích cải thiện ống kính vẫn chỉ là là tăng mức độ truyền sáng và giảm mức độ nhiễu tín hiệu. Chưa kể, ống kính xếp là của nhà cung ứng: sớm hay muộn, các hãng khác cũng sẽ có ống kính xếp mà thôi.

Giới hạn tiếp theo đến từ lịch sử. Ảnh số đã có hơn 40 năm phát triển – phần lớn những gì có thể được thực hiện trên cảm biến và ống kính đều đã được thực hiện từ rất lâu rồi.

Năm 2014, Apple đã qua mặt giới hạn vật lý của ống kính bằng cách "gian lận": đưa ống kính ra ngoài thân máy. Khi bỏ cổng 3.5, phó chủ tịch phụ trách kỹ thuật phần cứng của Apple, Dan Riccio, cũng khẳng định: "Cổng tai nghe chiếm chỗ của công nghệ camera, của vi xử lý và của pin".

Những tranh cãi về mặt thiết kế nổ ra, nhưng những quyết định gây tranh cãi này sau đó cũng nhanh chóng phổ biến lên những chiếc smartphone đối thủ. Bởi thực tế thì họ không có nhiều lựa chọn: 1, gây tranh cãi, 2, bỏ các linh kiện quan trọng bên trong, hay là 3, tăng độ dày của smartphone? Đâu mới là lựa chọn chấp nhận được?

Đáp án đúng nhất là 4: ngừng tìm cách giải quyết các vấn đề vật lý. Nếu đến cuối cùng bạn chỉ có thể thu về từng đó ánh sáng, cách duy nhất để bứt phá là sáng tạo trên tất cả những gì bạn có thể thu về.

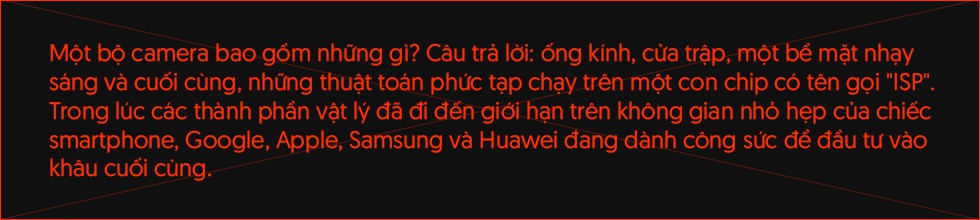

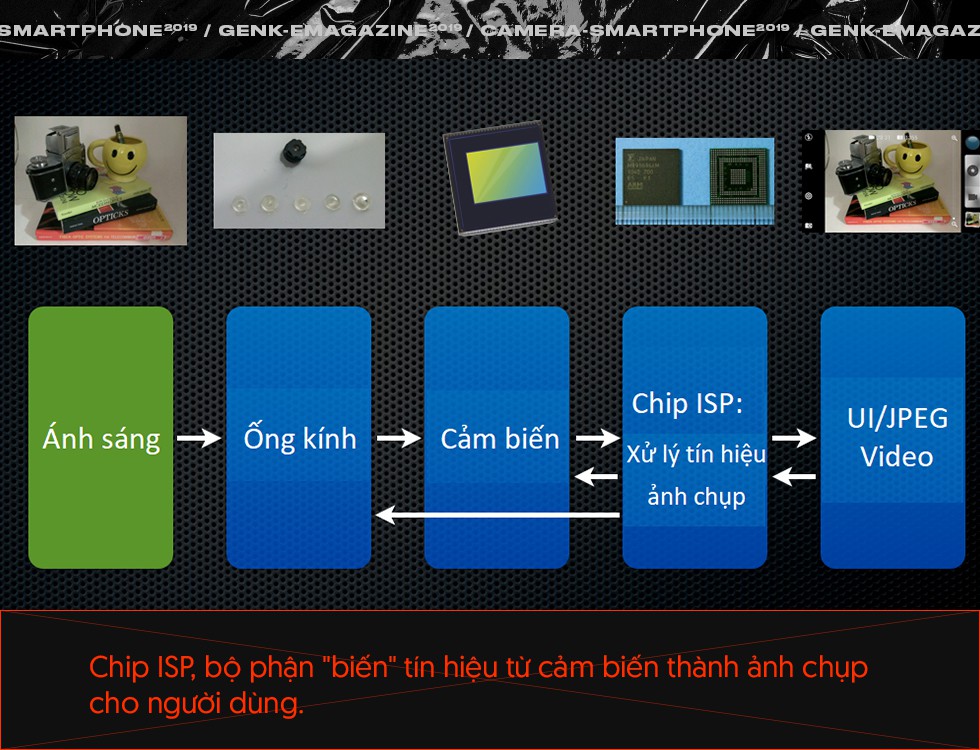

Tương lai bởi thế nằm ở tín hiệu truyền từ cảm biến đến con chip ISP. Dù được ít người nhắc đến nhưng ISP (Image Signal Processor – Vi xử lý Tín hiệu Hình ảnh) vốn đã luôn là thành phần không thể thiếu của hệ thống camera số. Nói một cách đơn giản, chúng biến tín hiệu từ cảm biến trở thành những bức ảnh có thể xem được. Cách thực hiện của mỗi nhà sản xuất đều sẽ khác nhau, từ format lưu dữ liệu RAW cho đến các biện pháp xử lý JPEG.

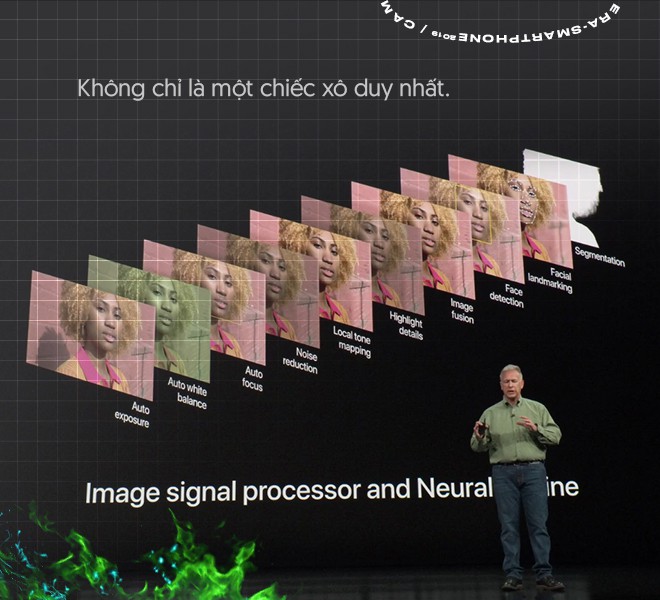

Trong một thời gian dài, chẳng có mấy ai quan tâm đến khâu cuối cùng này, ngoại trừ một vài phép chỉnh sửa độ tương phản hay màu sắc đơn giản qua filter số. Đến đầu thập niên 2000, vai trò của những con chip mới được chú ý khi máy ảnh có thể tự động nhận diện vật thể để lấy nét. Dùng chip để phát hiện và theo dõi khuôn mặt hay đôi mắt trong bức hình, máy ảnh số và sau này là smartphone có thể đem đến những bức ảnh chân dung chất lượng hơn trong điều khiển sáng phức tạp. Trong nhiếp ảnh thể thao, những hệ thống tự động lấy nét sẽ giúp người chụp bớt vất vả hơn rất nhiều.

Đáng tiếc rằng trên DSLR, phần "số hóa" cũng chỉ có thể tiến được đến vậy. Đâu đó, bằng cách cải thiện những con chip, người ta có thể tăng cường số khung hình trong một giây hoặc tăng thêm vài vòng tính toán nhằm cải thiện mức độ lưu giữ màu sắc/chi tiết. Lấy nét tự động đã trở thành một tính năng quá quen thuộc. Các nhà sản xuất lại say mê tìm cách cải thiện các yếu tố vật lý trên những cỗ máy có kích cỡ và trọng lượng cao gấp hàng chục lần chiếc iPhone của Apple.

Phải đến khi smartphone trở thành thị trường màu mỡ nhất thế giới, người ta mới buộc phải quay về phát triển tiếp những con chip ISP. Từ 2016 đến 2018, mỗi năm lượng smartphone bán ra trên toàn cầu đạt khoảng 1,5 tỷ chiếc. Hàng tỷ thiết bị này, dù là Apple, Samsung, Huawei hay Google, tất cả đều phải chịu chung những giới hạn vật lý nhất định. Smartphone của họ đều chỉ dày khoảng 10mm trở xuống. Không gian cải tiến cảm biến và lens đã cạn kiệt.

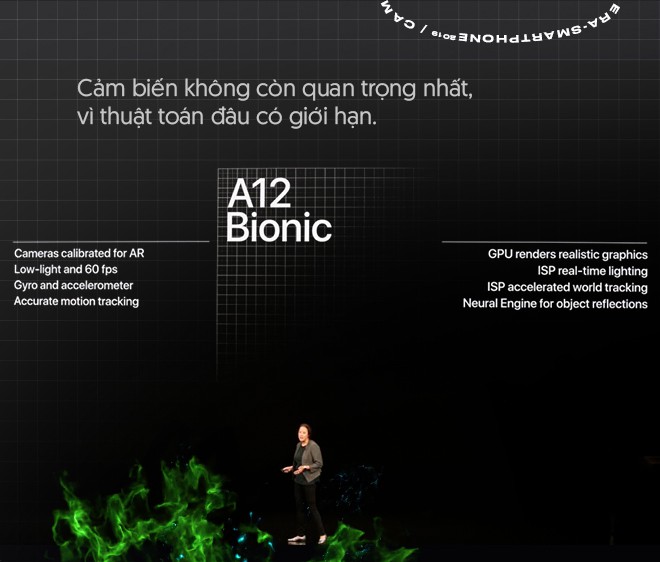

Thật may mắn, smartphone lại mang trong mình một điểm khác biệt cơ bản so với DSLR: chúng là những chiếc máy tính thực thụ, với khả năng xử lý phần mềm trên các hệ điều hành đầy đủ và vô số những con chip tùy biến. Những con chip ISP thế hệ mới nằm trên các mẫu SoC siêu tân tiến như Snapdragon, Apple A và Exynos. Khi chip di động tiếp tục bùng nổ về sức mạnh - thậm chí còn tích hợp cả các bộ xử lý neuron, các các nhà sản xuất smartphone bắt đầu vẽ ra một hướng đi mới cho nhiếp ảnh.

Họ bắt đầu phá vỡ khái niệm "khoảnh khắc".

Triết lý ở đây đã thay đổi hoàn toàn: bị giới hạn bởi chiếc xô, smartphone sẽ không hứng nước trong một thời điểm duy nhất. Google, Apple, Huawei và Samsung chuyển sang hứng liên tiếp nhiều xô nước trong một khoảng thời gian cực ngắn. Thay vì thu lại một khoảnh khắc duy nhất, smartphone sẽ thu lại hàng chục khung hình – ví dụ như 15 khung hình trước và sau "khoảnh khắc" nhấn chụp chẳng hạn.

Thu về 15 khung hình là thu về một lượng "nguyên liệu" khổng lồ, khi mỗi khung hình có khoảng 12 triệu điểm ảnh (Pixel, iPhone v...v...). Trước đây, sức mạnh tính toán của những con chip thường sẽ không đủ để xử lý lượng nguyên liệu khổng lồ ấy để bạn thu lại khoảnh khắc trong tích tắc. Nhưng nay, với kiến trúc 64-bit và chu trình 7nm, với engine neuron để chạy thuật toán máy học, 15 hay thậm chí là 30 khung hình trong tích tắc đã trở thành chuyện nhỏ.

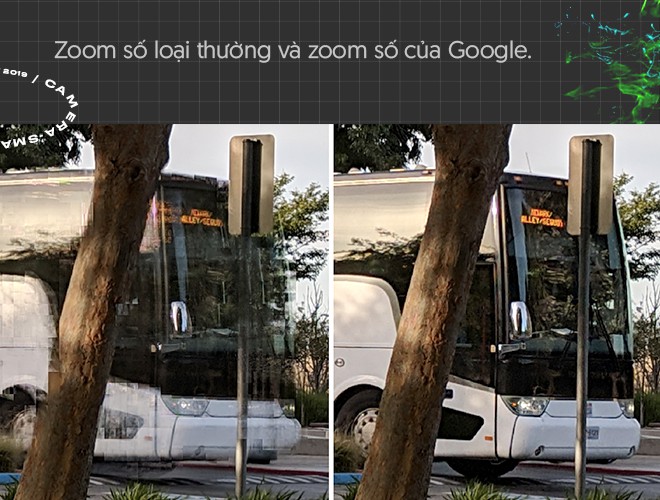

Kết hợp khung hình chính là cách đã được Google tận dụng để tạo ra một tính năng "hoang đường" trên Pixel 3 năm ngoái: zoom số với chất lượng gần như zoom quang học. Như bạn đã biết, zoom số thực chất là cắt ảnh (crop) và do đó sẽ khiến người dùng mất dữ liệu. Trên bất kỳ một chiếc máy ảnh nào khác, zoom số sẽ mang về một bức ảnh có độ phân giải thấp hơn, kém chi tiết hơn.

Google làm thế nào để tạo ra zoom số "như thật"? Đầu tiên, khi zoom số, Pixel 3 vẫn cứ "crop" hình ảnh, thu về các khung hình nhỏ, kém chi tiết. Nhưng Pixel 3 không chỉ thu về 1 khung hình crop xấu xí: khi dùng Super Res Zoom, camera trong Pixel 3 sẽ di chuyển các khoảng cách siêu nhỏ và thu lại 4 khung hình crop gần giống nhau ở các góc hình chỉ cách nhau duy nhất 1 điểm ảnh.

Dựa trên vị trí tương đối của từng khung hình, con chip Pixel Visual Core sẽ tiến hành lồng ghép 4 khung hình này lên nhau một cách chính xác nhất. Kết quả là bức ảnh zoom số không khác biệt nhiều so với zoom quang học.

Về bản chất, Super Res Zoom giống hệt tính năng rất quen thuộc là HDR. Với HDR, camera sẽ so sánh nhiều bức hình chụp liên tiếp có độ phơi sáng khác nhau để phát hiện các khu vực bị cháy sáng hoặc thiếu sáng. Sau đó, camera kết hợp chúng lại và điều chỉnh để đem lại thành phẩm hợp lý nhất.

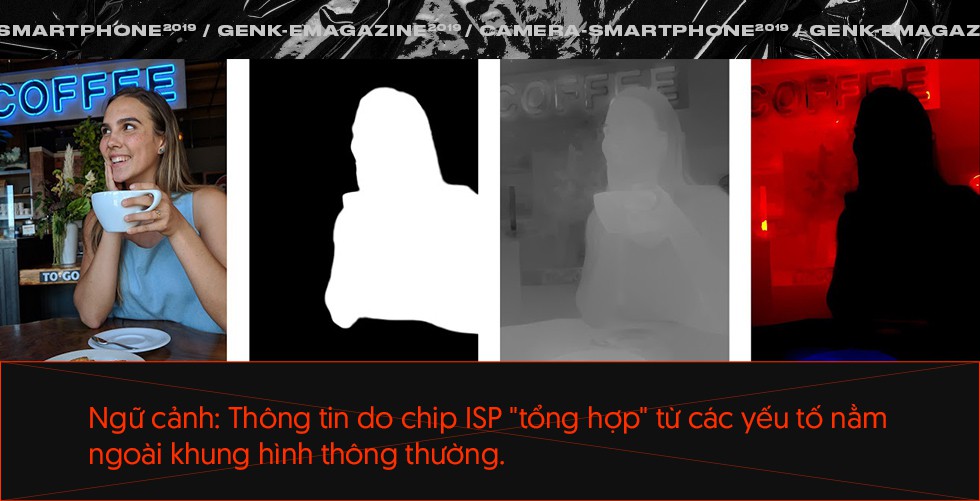

Với HDR và Super Res Zoom, so sánh (và lồng ghép) các khung hình đã giúp tạo ra một loại dữ liệu đặc biệt gọi là "ngữ cảnh". Không hề có mặt trên ảnh chụp "loại thường", loại dữ liệu dư thừa này cho phép smartphone hiểu hơn về ảnh chụp của bạn. Nếu bạn chỉ chụp về 2 khung hình riêng rẽ, chiếc máy ảnh/smartphone của bạn sẽ không thể nào đoán ra đâu là khu vực bị cháy sáng. Nếu bạn chụp 4 khung hình crop độ phân giải thấp, chiếc smartphone của bạn cũng chẳng thề lồng ghép 4 khung hình lại để tạo ra một bức ảnh độ phân giải cao, sắc nét như zoom quang.

Các thông tin ngữ cảnh đều được ISP tổng hợp từ các yếu tố từ ngoài "khoảnh khắc" của bạn. Đó có thể là sự khác biệt giữa cùng 1 vùng ảnh trên 2 bức hình có ISO khác nhau, là bản đồ 3D thu được từ 2 camera đặt liền kề hay đơn giản chỉ là khoảng cách từ smartphone đến chủ thể. Nếu chỉ chụp 1 khoảnh khắc, bức ảnh bạn thu về chỉ là những gì ống kính và cảm biến thu lại. Nhưng có ngữ cảnh, bức ảnh bạn thu về là một tác phẩm của nhiếp ảnh điện toán:

Thực tế, chỉ thuật toán thôi là không đủ, nhiếp ảnh điện toán phải có cả vật lý hỗ trợ nữa: Super Res Zoom đòi hỏi camera phải di chuyển khoảng cách cực nhỏ, hoặc ảnh chụp bokeh đòi hỏi có 2 camera kép. Song, thuật toán vẫn là yếu tố cốt lõi.

Bạn có thể nhìn vào ảnh xóa phông để hiểu vai trò của ISP quan trọng đến thế nào. Trên smartphone cam kép, 2 camera có khẩu độ và vị trí đặt khác nhau sẽ tạo ra 2 khung hình khác nhau. Dựa vào vị trí của 2 camera trong thân máy, smartphone sẽ dựa vào 2 khung hình thành để tạo ra không gian 3D "ảo". Khi đã "hình dung" ra được không gian 3D, smartphone sẽ tiến hành làm mờ các vật thể đứng đằng sau chủ thể.

Nhưng vì linh hồn là thuật toán, Google có thể áp dụng cùng một nguyên lý để tạo ra ảnh xóa phông trên smartphone cam đơn. Pixel 2 và Pixel 3 đều có cảm biến sử dụng điểm ảnh "kép", gồm 2 diode quang khác nhau. Khi chụp ảnh, mỗi diode sẽ thu về một điểm ảnh riêng. Nói cách khác, cùng 1 cảm biến, camera của Pixel 2 thu về 2 bức ảnh trong cùng một khoảnh khắc – giống như là có 2 camera vậy.

Một lần nữa, 2 camera này sẽ được so sánh với nhau. Một bản đồ 3D lại được tạo ra, và dựa vào đó, Pixel biết đâu là những vật thể nằm sau chủ thể để làm mờ. Thậm chí, độ chính xác của hiệu ứng làm mờ còn được cải thiện, vì 2 khung hình chỉ cách nhau nửa pixel mà thôi.

Năm 2019, Apple học hỏi lại cơ chế "xóa phông cam đơn" của Google trên iPhone XR. Nhưng Apple cũng có những tính năng nhiếp ảnh điện toán của riêng mình: với iPhone X, nhà Táo vén màn khả năng điều chỉnh độ sáng phản chiếu trên bức ảnh chân dung. Ngữ cảnh ở đây không đến từ camera đơn (hay pixel kép) mà đến từ engine 3D của Face ID: khi đã có mô hình 3D, Portrait Lightning sẽ thực hiện phép giả lập "điều gì sẽ xảy ra khi ánh đèn studio được đặt trước mặt người mẫu" và áp dụng các thay đổi tính toán được lên bức ảnh cuối.

Tiếp đến Samsung. Tuy chậm chân rõ rệt so với 3 cái tên còn lại, Samsung vẫn có những sáng tạo của riêng mình mà chưa đối thủ nào nghĩ đến: Galaxy Note9 và Galaxy S10 có khả năng tự động phát hiện người nhắm mắt trong bức ảnh, có thể phát hiện ống kính đang bị bám bẩn và có thể tự động thông báo nếu ảnh chụp bị mờ hoặc bị ngược sáng. Năm nay, Galaxy S10 còn có khả năng Shot Suggestion, gợi ý cho người dùng cách phối hình để lưu trữ chuẩn mực nhất.

Ngữ cảnh ở đây thậm chí còn không đến từ ống kính camera: trước khi xuất xưởng, con chip ISP của Samsung đã "học" từ 100 triệu bức ảnh. Dataset khổng lồ này giúp chiếc S10 "hiểu" các dấu hiệu của ống kính bị bám bẩn, hiểu người mẫu nên ở đâu để tạo ra khung hình chuẩn mực.

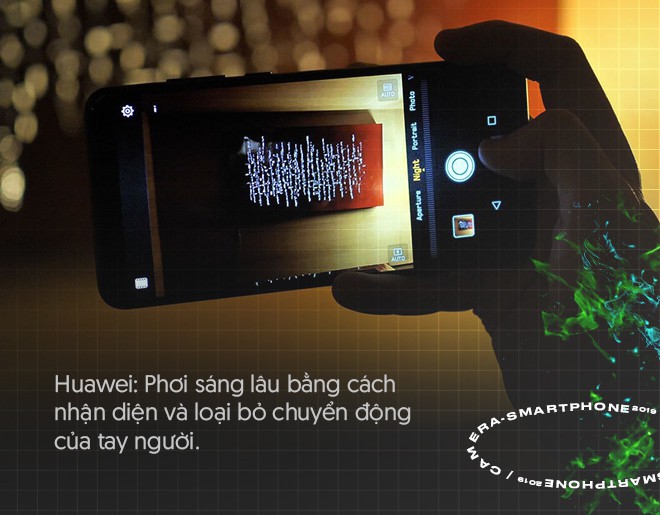

Một đối thủ mới nổi khác là Huawei cũng đang tìm cách tạo ra dấu ấn của riêng mình trên nhiếp ảnh điện toán. Năm ngoái, trên P20 Pro và Mate 20 Pro, Huawei mở ra khả năng chụp ảnh thiếu sáng cực tốt bằng cách phơi sáng bức ảnh trong vòng 6 giây liên tục. Khoảng thời gian như vậy sẽ là bất khả thi với máy ảnh thường, nhưng AI trên P20 và Mate 20 có thể tự động phát hiện chuyển động của máy. Hiểu được ngữ cảnh – quá trình chuyển động của tay khi phơi sáng, chip ISP sẽ thực hiện phép xử lý bù trừ. Khung hình bởi vậy sẽ đứng yên khi tay người dùng di chuyển.

Năm nay, Huawei lại copy Super Res Zoom của Google. Bằng cách lồng ghép các khung hình do bộ 3 camera thu lại, chiếc P30 và P30 Pro sẽ tạo ra những bức ảnh zoom 3X số có chất lượng gần giống như zoom thật. Kết hợp kiểu zoom số này với zoom quang học (qua ống kính xếp), P30 có thể thực hiện phóng to đến 50X mà không mất nhiều chi tiết.

Thoạt nhìn, nhiếp ảnh điện toán mang đến những giải pháp quá mức phức tạp cho những vấn đề đơn giản. Để tạo ra bức hình chân dung giả lập sáng, Apple thực chất phải tạo ra mô hình 3D của khuôn mặt người mẫu, phải "hiểu" được vị trí của từng đường nét để "đổ sáng" chính xác. Để làm điều tương tự trong đời thực, người ta chỉ cần... di chuyển đèn. Để chụp ảnh bokeh, bạn chỉ thay lens. Để zoom quang học, bạn cũng chỉ cần vặn ống kính hay đơn giản hơn là... bước chân đến gần chủ thể. Hay, để phơi sáng 6 giây, bạn chỉ cần một chiếc tripod.

Còn với nhiếp ảnh điện toán, các kỹ sư thậm chí phải suy tính từng pixel trên ma trận 3 chiều, phải tạo ra những thuật toán tối ưu nhất có thể (để xử lý hàng chục triệu điểm ảnh trong tích tắc), và phải tạo ra những bộ dữ liệu mẫu khổng lồ để "đào tạo" cho AI của họ.

Muốn phát triển thuật toán AI, những gã khổng lồ phải bỏ tiền ra thuê những kỹ sư, những nhà khoa học dữ liệu hàng đầu thế giới. Muốn có ISP chất lượng, họ sẽ phải cạnh tranh lẫn nhau trên lĩnh vực khốc liệt nhất, tốn kém nhất – thiết kế chip.

Tại sao lại phải làm như vậy? Câu trả lời đơn giản chỉ là: khác với vật lý, điện toán không có giới hạn. Trong những năm vừa qua, chip di động đã tiên phong cho hành trình đi đến điểm kết thúc của định luật Moore – chúng thừa sức để chạy những bộ máy AI giả lập hiệu ứng trên smartphone. Khi 10 hay thậm chí là 100 khung hình cũng không thể gây khó cho ISP (hay CPU, GPU), giới hạn cho những gì camera smartphone có thể làm được thực chất lại là trí tưởng tượng của các kỹ sư phần mềm. Lồng ghép pixel, dựng mô hình 3D, giả lập hiệu ứng trong không gian 3D... mở ra vô số kịch bản sử dụng.

Đó đều là những thử thách khó nhằn, nhưng may mắn thay, đó lại là những thử thách nằm trong tầm tay của Apple và Google. Thay vì bỏ ra hàng triệu đô để tạo ra những cải tiến nhỏ nhặt, Apple và Google chỉ cần tập trung vào thế mạnh cốt lõi của họ: code, và silicon.

Bên trong nhiếp ảnh điện toán là đường đến tương lai. Đó là một lĩnh vực đắt đỏ, nhưng cũng là con đường duy nhất mà các hãng có thể đi. Không cần phải suy nghĩ, các ông lớn đều hiểu họ phải đặt code và silicon lên trên các yếu tố vật lý, vốn đã đi đến giới hạn từ lâu.

Hơn hết, mọi cái giá đều sẽ là quá rẻ để nắm lấy ngôi vương trên thị trường camera smartphone. Qua nhiều năm, trải nghiệm smartphone đã trở nên quá quen thuộc và nhàm chán. Cuộc đua màn hình đang đi đến cái đích tràn viền thông qua những thiết kế... ngớ ngẩn như "tai thỏ" hay camera thò thụt. Cuộc đua cấu hình cũng đã nguội lạnh khi smartphone tầm trung vẫn thừa đủ để chạy mượt những tựa game mới. Chỉ có nhu cầu camera là không có điểm dừng: smartphone chụp càng đẹp, càng dễ thu hút sự chú ý của người dùng.

Giới hạn không còn là của cả thị trường nữa. Từng ông lớn sẽ có cách để thúc đẩy camera theo nguyện vọng và năng lực của riêng mình, bởi nhiếp ảnh điện toán không phải là lợi thế "muốn copy là copy được" như màn hình tai thỏ, camera kép hay cảm biến vân tay dưới màn. Xiaomi hay OPPO có thể copy thiết kế của Apple, có thể sử dụng chung nhiều nhà cung ứng – bao gồm cả cảm biến Sony. Nhưng muốn có tính năng đổ sáng chân dung như Apple, Xiaomi sẽ phải tự thiết kế chip, tự xây dựng thuật toán cho riêng mình.

Như thế, những dòng code sẽ quyết định cho tương lai của cả ngành công nghiệp smartphone.