ChatGPT cần 'uống' bao nhiêu lít nước để trả lời 50 câu hỏi: Nhìn qua tưởng không nhiều, nhưng nếu tính tổng lượng tiêu thụ sẽ thấy bất ngờ

Một nghiên cứu mới từ các nhà nghiên cứu tại Đại học Colorado Riverside và Đại học Texas Arlington ở Mỹ đã đưa ra một số hiểu biết về mức độ tiêu thụ nước của ChatGPT.

Chatbot AI của OpenAI đã trở nên phổ biến nhờ sự đa tài của nó trong việc trả lời chính xác các câu hỏi của người dùng. Sau khi được cung cấp cho công chúng để thử nghiệm vào tháng 11 năm ngoái, chatbot AI này đã được sử dụng cho mọi thứ, từ viết thơ ca đến lập trình, thậm chí trả lời các câu hỏi trong kỳ thi dành cho sinh viên y khoa.

Tuy nhiên, bất chấp việc ChatGPT đã thu hút được hàng trăm triệu người dùng trên thế giới, vẫn có rất ít nghiên cứu về tác động của AI này đối với môi trường.

Một nghiên cứu mới từ các nhà nghiên cứu tại Đại học Colorado Riverside và Đại học Texas Arlington ở Mỹ đã đưa ra một số hiểu biết về mức độ tiêu thụ nước của ChatGPT, cho thấy lượng nước đáng kinh ngạc của chatbot AI này tiêu thụ trong quá trình hoạt động.

Chatbot AI sử dụng nước như thế nào?

Các số liệu tiêu thụ nước của nghiên cứu đề cập đến lượng nước sạch được các trung tâm dữ liệu sử dụng để tạo ra điện và làm mát các thiết bị của máy chủ.

Hầu hết sức mạnh điện toán đám mây của các chatbot nổi bật như ChatGPT đều dựa trên nền tảng là hàng nghìn máy chủ bên trong các trung tâm dữ liệu nằm ở khắp thế giới.

Bất kỳ ai đã dành vài giây trong phòng máy chủ của công ty đều biết rằng trước tiên bạn cần mặc một chiếc áo len. Các phòng máy chủ được giữ mát, thường ở nhiệt độ từ 10 đến 26 độ C để tránh thiết bị gặp trục trặc. Việc duy trì nhiệt độ lý tưởng đó là một thách thức thường xuyên vì bản thân các máy chủ chuyển đổi năng lượng điện thành nhiệt. Các thiết bị tản nhiệt thường được triển khai để cố gắng chống lại sức nóng đó và giữ cho các phòng ở nhiệt độ lý tưởng bằng cách làm bay hơi nước lạnh.

Các trung tâm dữ liệu lớn phục vụ cho AI thường cần một lượng lớn nước sạch để tản nhiệt, nhằm giúp cho các t hiết bị luôn hoạt động trong khoảng nhiệt độ lý tưởng. Ảnh: Internet

Để mang lại hiệu quả tốt cho việc làm mát, các thiết bị tản nhiệt đương nhiên cần một lượng nước khổng lồ để chạy và duy trì. Các nhà nghiên cứu ước tính khoảng một gallon nước được tiêu thụ cho mỗi kilowatt giờ sử dụng trong một trung tâm dữ liệu trung bình. Không phải bất kỳ loại nước nào cũng có thể được sử dụng. Các trung tâm dữ liệu lấy từ các nguồn nước ngọt, sạch để tránh sự ăn mòn hoặc sự phát triển của vi khuẩn có thể đi kèm với nước biển. Nước ngọt cũng rất cần thiết để kiểm soát độ ẩm trong phòng.

Với riêng trường hợp của chatGPT, mỗi khi trả lời từ 20 đến 50 câu hỏi được đặt ra bởi người dùng, chatbot AI này có thể 'uống', hay tiêu thụ một chai nước 500ml. Tổng lượng nước được đánh giá là khổng lồ khi thực tế số người dùng lên đến cả trăm triệu, chưa kể hàng tỷ câu hỏi được đưa ra.

"Mặc dù một chai nước 500ml có vẻ không quá nhiều, nhưng tổng lượng nước ChatGPT sử dùng vẫn cực kỳ lớn, trong bối cảnh AI này thu hút hàng trăm triệu người dùng," các nhà nghiên cứu cho biết.

Các nhà khoa học cho rằng chỉ riêng trong quá trình đào tạo GPT-3, Microsoft có thể đã tiêu tốn một lượng nước đáng kinh ngạc là 700.000 lít, tương đương với lượng nước đủ làm mát một lò phản ứng hạt nhân. Xét về quy mô, chỉ riêng siêu máy tính mới nhất của Microsoft đã yêu cầu một thiết bị làm mát cỡ lớn, để phục vụ và và giải nhiệt cho 10.000 card đồ họa và hơn 285.000 lõi bộ xử lý, mang đến cái nhìn thoáng qua về quy mô hoạt động rộng lớn đằng sau trí tuệ nhân tạo, cũng như lượng nước tiêu thụ.

Các nhà nghiên cứu ước tính, các mô hình ngôn ngữ thế hệ tiếp theo, vốn phức tạp và thông minh hơn như GPT-4 có thể tiêu thụ nhiều nước hơn trong quá trình đào tạo. Tuy nhiên, cho đến nay, vẫn chưa có bất kì dữ liệu công khai nào để đưa ra ước tính chính xác lượng nước chatbot AI tiêu thụ.

Các vấn đề về tiêu thụ nước không chỉ giới hạn ở trường hợp của OpenAI hoặc AI. Vào năm 2019, Google được cho là đã sử dụng hơn 2,3 tỷ gallon nước cho các trung tâm dữ liệu chỉ ở ba tiểu bang.

Gã khổng lồ công nghệ này hiện có 14 trung tâm dữ liệu trải rộng khắp Bắc Mỹ mà họ sử dụng để cung cấp năng lượng cho Google Search, bộ công cụ dành cho văn phòng, và gần đây là các mô hình ngôn ngữ lớn như LaMDa và Bard. Chỉ riêng LaMDA, theo bài báo nghiên cứu gần đây, có thể cần hàng triệu lít nước để đào tạo, lớn hơn GPT-3 vì một số trung tâm dữ liệu của Google được đặt ở các bang có thời tiết nóng như Texas.

Tuy nhiên, cần lưu ý rằng nước "tiêu thụ" sẽ được thải trở lại khí quyển thông qua các tháp tản nhiệt và không bị "thất thoát" khỏi vòng tuần hoàn nước. Tuy nhiên, cần có thời gian để nó quay trở lại Trái đất ở dạng lỏng một lần nữa.

Mặc dù vậy, các nhà nghiên cứu cũng bày tỏ lo ngại về việc tiêu thụ nước quá mức của AI có thể làm tổn hại đến nguồn cung cấp nước, đặc biệt là do hạn hán trong quá khứ và sự biến đổi môi trường xảy ra ở Mỹ và nhiều quốc gia khác.

Ngoài nước, các mô hình ngôn ngữ lớn mới cũng yêu cầu một lượng điện đáng kinh ngạc. Một báo cáo về AI của Đại học Stanford được công bố vào tuần trước xem xét sự khác biệt về mức tiêu thụ năng lượng giữa bốn mô hình AI nổi bật. Theo đó, GPT-3 của OpenAI đã thải ra 502 tấn carbon trong quá trình đào tạo.

Tổng hợp

NỔI BẬT TRANG CHỦ

-

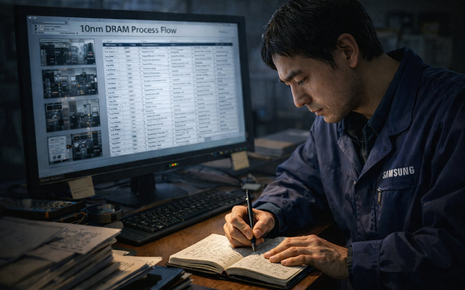

Không USB, không email, làm thế nào nhân viên Samsung tuồn quy trình 600 bước của công nghệ DRAM 10nm sang Trung Quốc?

Dù được bảo vệ nghiêm ngặt bằng nhiều thiết bị giám sát điện tử tối tân, cuối cùng bí mật công nghệ trị giá hàng nghìn tỷ của Samsung lại bị tuồn ra bằng hình thức truyền tin nguyên thủy nhất của loài người.

-

Bảy cú nhảy vọt công nghệ trong năm 2025 đẩy xe điện bước sang kỷ nguyên mới