Giới khoa học tìm ra bí ẩn về cách học hỏi của ChatGPT: rất tương đồng với con người nhưng nhanh gấp bội

Thay vì chỉ dựa vào dữ liệu huấn luyện được nạp vào, các mô hình AI như ChatGPT còn kết hợp với dữ liệu sẵn có bên trong để khái quát hóa và sản sinh ra kiến thức mới, tương tự như con người.

- Microsoft giáng đòn mới vào Google: đưa Bing Chat vào Windows 11, tiếp cận cả triệu người dùng trong nháy mắt

- Nghe OpenAI giải thích cặn kẽ về cách huấn luyện ChatGPT: giống như huấn luyện một chú chó

- Hóa ra Microsoft đã biết về “thái độ lồi lõm” của Bing Chat từ nhiều tháng trước khi ra mắt người dùng

Đối với các nhà khoa học và chuyên gia về trí tuệ nhân tạo, một trong những bí ẩn lớn nhất đằng sau các mô hình AI ngôn ngữ lớn hiện nay như GPT-3 của OpenAI và LaMDA của Google là khả năng học hỏi siêu nhanh. Thậm chí chúng có thể thực hiện rất tốt nhiều tác vụ mà chúng không được huấn luyện chuyên biệt để thực hiện.

Thông thường, để thực hiện được một tác vụ mới, các mô hình máy học phải trải qua quá trình huấn luyện trên dữ liệu mới – một quá trình đòi hỏi các nhà nghiên cứu phải nhập vào hàng nghìn điểm dữ liệu để nhận được kết quả đầu ra mong muốn – một công việc nhàm chán và tiêu tốn thời gian.

Trong tài liệu nghiên cứu mới được đăng tải trên arXiv, các nhà nghiên cứu tại Học viện Công nghệ Massachusetts, Đại học Stanford, và Google đã khám phá ra phần nào bí ẩn trong cơ chế đằng sau nó, được gọi là "học tập theo ngữ cảnh".

Ảnh Internet

Với cơ chế này, các hệ thống AI có thể học để thực hiện các tác vụ mới một cách đáng tin cậy chỉ với vài ví dụ cho trước và thậm chí còn có thể thành thạo một kỹ năng mới. Dựa vào một vài gợi ý nào đó, mô hình ngôn ngữ có thể tạo ra một danh sách các đầu vào và đầu ra, đồng thời tạo ra các dự đoán mới – thường là chính xác – về loại tác vụ mới nó chưa từng được huấn luyện trước đây.

Nhưng tại sao các mô hình này có khả năng học hỏi thay vì chỉ đơn thuần ghi nhớ dữ liệu?

Tác giả hàng đầu của tài liệu nghiên cứu này, Ekin Akyürek nói với trang Motherboard: "Học tập có liên quan đến hiểu biết trong hiện tại. Chúng tôi cho thấy có khả năng rằng, những mô hình này có thể học được từ những ví dụ ngay trong khi thực hiện mà không cần phải cập nhật bất kỳ thông số nào chúng tôi áp dụng cho mô hình."

Điều này có nghĩa là các mô hình AI không chỉ sao chép dữ liệu huấn luyện, nhiều khả năng nó được xây dựng trên các kiến thức trước đó – cách thức tương tự như con người và các loài động vật hiện nay. Nghĩa là thay vì chỉ dựa vào các dữ liệu huấn luyện mới được nạp vào, các mô hình này còn có thể dựa trên các dữ liệu sẵn có trong nó, so sánh nó với dữ liệu mới để tìm ra điểm chung, cũng như kết hợp các khái niệm đơn giản thành thứ phức tạp hơn.

Các nhà nghiên cứu không thử nghiệm lý thuyết của mình đối với ChatGPT hay các công cụ học máy phổ biến trong công chúng hiện nay. Thay vào đó, nhóm của Akyürek nghiên cứu trên các mô hình nhỏ hơn với những tác vụ nhỏ hơn. Nhưng vì chúng vẫn dựa trên cùng một loại mô hình ngôn ngữ, nên công trình nghiên cứu của họ vẫn cho thấy cái nhìn rõ ràng trong cơ chế vận hành của các mô hình AI nổi tiếng hiện nay.

Các mô hình AI có khả năng tạo ra các mô hình nhỏ hơn bên trong để khái quát hóa dữ liệu mới được nạp vào. Ảnh Internet

Để kiểm tra lý thuyết của mình, các nhà nghiên cứu nạp vào mô hình những dữ liệu tổng hợp hoặc những lời nhắc mà chương trình chưa từng thấy trước đây. Ngay cả như vậy, mô hình ngôn ngữ vẫn có thể khái quát hóa và suy luận ra kiến thức từ số ít dữ liệu này. Vì vậy các nhà nghiên cứu giả định rằng các mô hình AI học hỏi theo ngữ cảnh bằng cách tạo ra các mô hình nhỏ hơn bên trong chúng - mỗi mô hình nhỏ sẽ đảm nhiệm một khía cạnh nào đó của tác vụ mới để cuối cùng có thể khái quát hóa nó và tạo ra được kiến thức từ những dữ liệu mới.

Ví dụ, một mô hình AI khi học cách đếm các đối tượng trong một bức ảnh với một vài ví dụ cho trước. Theo giả định của các nhà nghiên cứu, nó có thể tạo ra các mô hình nhỏ hơn bên trong, đảm nhận việc mã hóa bức ảnh thành định dạng số nhị phân, thực hiện các phép tính logic bên trong nó và từ đó học được cách khái quát hóa hình ảnh đó, cũng như phân biệt được các đối tượng, màu sắc, hình khối bên trong nó.

Điều này tương đồng phần nào với cách con người hình tượng hóa các biểu tượng hoặc các biểu trưng khi học tập. Ví dụ như khi con người học toán, chúng ta không chỉ sử dụng đến các biểu tượng như con số và các hàm tính toán để thực hiện phép tính, mà còn dùng cả trực giác và khả năng hình tượng hóa để hiểu được các khái niệm trong đó.

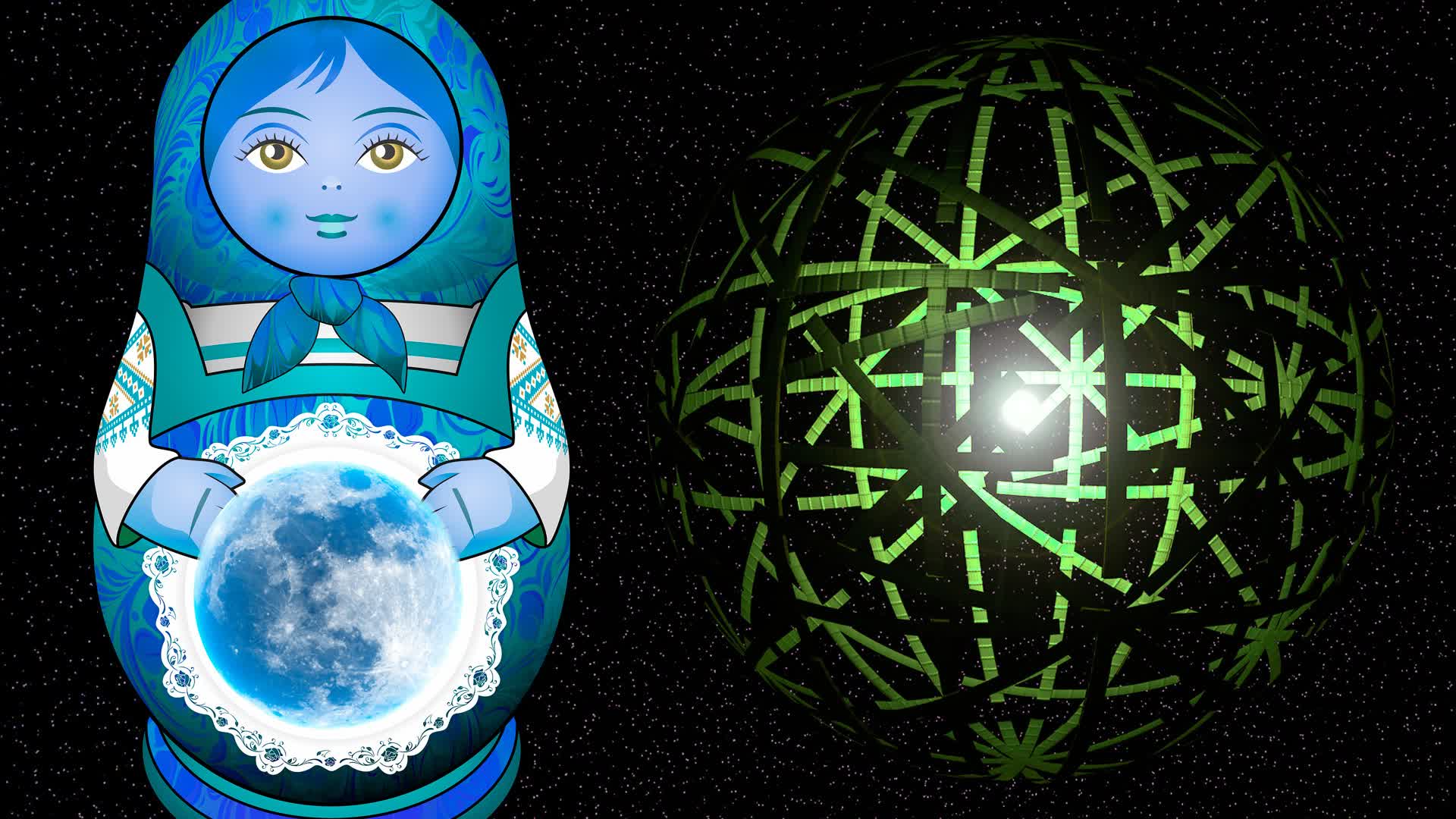

Giống như búp bê Nga Matryoshka

Để kiểm nghiệm giả thuyết của mình, các nhà nghiên cứu đã phân tích Transformer, mô hình học sâu đang là nền tảng cho các mô hình ngôn ngữ lớn nổi tiếng hiện nay, vận hành dựa trên ý tưởng về các lớp lọc sự chú ý để theo dõi mối quan hệ trong các chuỗi dữ liệu, như từ ngữ trong một câu.

Việc các mô hình AI lớn có thể tự tạo ra các mô hình nhỏ hơn bên trong được ví giống như Búp bê Nga Matryoshka. Ảnh Internet

Bằng cách theo dõi hoạt động của mô hình, các nhà nghiên cứu nhận ra rằng mô hình Transformer của họ có thể tự viết các mô hình học máy ở những trạng thái ẩn, hoặc khoảng trống giữa các lớp đầu vào và đầu ra. Theo Akyürek, điều này cho thấy rằng, về lý thuyết cũng như thực nghiệm, có khả năng dường như các mô hình ngôn ngữ tự phát minh ra "các thuật toán học tập được nghiên cứu kỹ lưỡng và nổi tiếng".

Nói cách khác các mô hình ngôn ngữ lớn hơn hoạt động bằng cách tạo ra và huấn luyện nên các mô hình ngôn ngữ đơn giản hơn, nhỏ hơn. Mô hình này giống như búp bê Matryoshka của Nga – với nhiều lớp mô hình có kích thước khác nhau, lớp nhỏ hơn lại nằm trong một lớp khác lớn hơn.

Trong tuyên bố về nghiên cứu này, nhà khoa học Mark Lewis của Facebook AI Research cho biết, nghiên cứu này là "bước đệm để hiểu hơn về việc làm thế nào các mô hình ngôn ngữ có thể học được các tác vụ phức tạp hơn và sẽ giúp các nhà nghiên cứu thiết kế những phương pháp huấn luyện tốt hơn dành cho các mô hình ngôn ngữ để cải thiện hơn nữa hiệu suất của chúng."

Tiềm năng thay đổi cách con người tiếp nhận và xử lý thông tin

Trong khi Akyürek đồng tình rằng các mô hình ngôn ngữ như GPT-3 sẽ mở ra nhiều khả năng mới cho khoa học, ông cũng cho biết chúng sẽ thay đổi cách con người tiếp nhận và xử lý thông tin.

Cách thức hoạt động của các chatbot AI có thể làm thay đổi cách con người tiếp nhận và xử lý thông tin

Nếu như trước đây, con người thường nhập một lời nhắc (hay từ khóa) vào Google chỉ để truy xuất thông tin và sau đó chọn ra thông tin nào tốt nhất cho truy vấn bằng cách click vào đường link kết quả, thì giờ đây "GPT không chỉ truy xuất thông tin đó từ web mà còn xử lý nó cho bạn. Đó là lý do quan trọng vì sao phải tìm hiểu gợi ý các mô hình này như thế nào đối với mỗi dữ liệu mà bạn cần xử lý."

Tất nhiên, việc để các hệ thống tự động xử lý thông tin hoàn toàn sẽ gây ra nhiều loại vấn đề. Các nhà nghiên cứu về đạo đức AI liên tục cho thấy những hệ thống như ChatGPT đang sao chép các thiên kiến phân biệt chủng tộc và giới tính như thế nào và rất khó giảm nhẹ cũng như không thể loại bỏ hoàn toàn nó.

Cho dù vẫn còn nhiều điều không chắc chắn về những gì các mô hình học tập trong tương lai có thể thực hiện hay thậm chí cả các mô hình hiện tại, kết luận của nghiên cứu này cho biết, việc học tập theo ngữ cảnh có thể được sử dụng để giải quyết nhiều vấn đề mà lĩnh vực học máy chắc chắn sẽ gặp phải.

NỔI BẬT TRANG CHỦ

-

VN làm thành công dự án đầu tiên trên TG trong lĩnh vực nuôi sống một nửa nhân loại: Vừa áp dụng robot AI

Loại robot này được kỳ vọng sẽ giúp giảm chi phí đầu vào trong dự án đặc biệt của Việt Nam.

-

NVIDIA chuẩn bị ra mắt GeForce RTX 5050 với 9 GB VRAM tại Computex 2026