Hai nhà nghiên cứu Trung Quốc công bố hệ thống máy tính nhìn mặt biết tội phạm, bị lên án kịch liệt

Nhiều người cho rằng để cho hệ thống máy tính "nhìn mặt mà bắt hình dong" là một phương pháp trái với đạo đức.

Một số nhà nghiên cứu Trung Quốc vừa đưa ra một bản báo cáo nghiên cứu gây tranh cãi, thậm chí cả sự phẫn nộ trong công chúng. Báo cáo khoa học về machine learning mô tả việc hệ thống máy tính sẽ quyết định xem một người có vô tội hay không bằng cách nhìn mặt của họ.

Bản báo cáo có tên “Can thiệp tự động vào việc xác định khả năng phạm tội dựa vào hình ảnh khuôn mặt” được hai nhà khoa học Xiaolin Wu và Xi Zhang từ Đại học Giao thông Thượng Hải đăng tải. Xác nhận rằng hệ thống máy tính có thể “nhìn mặt bắt hình dong”, xác định xem người ta có phải là tội phạm không dựa trên các chi tiết họ lấy được từ khuôn mặt.

Robot trang bị công nghệ này sẽ là tương lai của ngành cảnh sát?

Họ nói rằng những thử nghiệm đã được tiến hành một cách thành công và từ đây, họ có thể phác thảo ra những điều luật về “những nét mặt thường thấy của những người không phạm tội”.

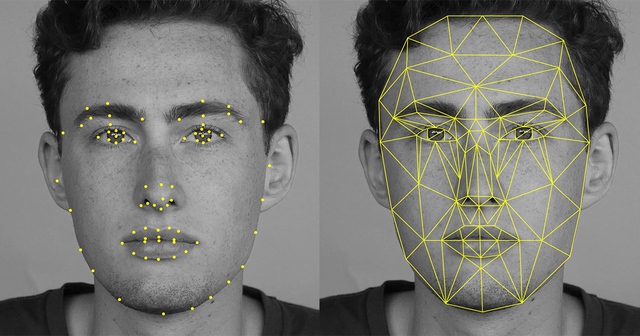

Hai nhà khoa học này mô tả rằng thuật toán của họ có thể sánh ngang hàng hay thậm chí vượt trội hơn khả năng nhận dạng khuôn mặt của con người, nhất là trong việc thẩm định xem khuôn mặt ấy có khả năng phạm tội hay không.

Nhưng một số người khác cho rằng họ đạt được điều này là do họ đã đưa những thành kiến nhất định vào trong hệ thống trí tuệ nhân tạo cũng như những thuật toán machine learning này. Máy tính có thể đã dựa vào những thành kiến ấy để đưa ra những suy đoán lệch lạc của mình.

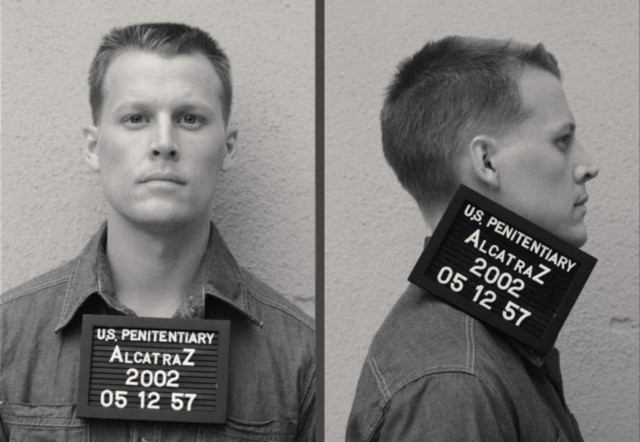

Những hình ảnh được hai nhà khoa học Trung Quốc sử dụng là hình nam giới từ trong độ tuổi từ 18 tới 55, những khuôn mặt người Trung Quốc không râu ria, không sẹo hay không có bất kì dấu hiệu dễ nhận biết nào.

Hai anh Wu và Zhang cũng nói rõ rằng họ đã không sử dụng hình chân dung tội phạm của cảnh sát để thử nghiệm. Họ đã loại bỏ yếu tố chung của con người khỏi quá trình đánh giá. Khi mà thông tin vẫn còn được điều chỉnh kĩ càng, liệu rằng thành kiến của con người có còn tồn tại trong quá trình thẩm định kia của máy tính?

Anh Wu nói rằng không có thành kiến nào được đưa vào và thực tế, những kết quả đầu tiên của thử nghiệm này đã có từ một năm trước. “Chúng tôi đã kiểm tra thông tin kĩ càng, tiến hành rất nhiều thử nghiệm để tìm ra vấn đề trong hệ thống nhưng chúng tôi không tìm thấy gì”.

Đây là cách quá trình đánh giá trên hoạt động:

Xiaolin và Xi đưa vào hệ thống một thuật toán machine learning gồm hình ảnh khuôn mặt của 1.856 người (một nửa trong số đó là tội phạm), theo dõi quá trình lọc của máy và xem xét, phân tích các thức mà nó luận ra được ai có thể là tội phạm. Một hệ thống phân loại riêng biệt được sử dụng, mỗi hệ thống lại có một phương pháp phân tích khuôn mặt khác nhau.

Họ tìm ra được rằng cả bốn hệ thống đều thành công, rằng khuôn mặt của tội phạm có những điểm khác biệt mấu chốt so với những người “bình thường”. Hơn nữa, “mức độ thay đổi trong các khuôn mặt của tội phạm lớn hơn rất nhiều so với những người thường”, Xiaolin và Xi viết trong báo cáo kết quả của mình.

“Cả bốn hệ thống phân loại đều thành công trong việc tìm ra những điểm đặc biệt trong khuôn mặt của tội phạm, dù rằng có rất nhiều ý kiến trái chiều về phương thức xác định khuôn mặt này”, hai nhà nghiên cứu viết. “Bên cạnh đó, chúng tôi tìm ra được những cấu trúc đặc biệt để phát hiện ra tội phạm như môi cong, khóe mắt dài hay góc độ đặc biệt giữa mũi và miệng”. Hệ thống phân loại mặt tốt nhất có tên Mạng lưới Thần kinh Cuộc – Convolutional Neural Network có độ chính xác lên tới 89,51%.

Họ kết luận rằng mình “đã thể hiện được rằng với quá trình machine learning được giám sát chặt chẽ, những hệ thống phân loại khuôn mặt đã có thể phân định được đâu là tội phạm”.

Dù hai anh thừa nhận rằng báo cáo khoa học của mình “không đạt chuẩn để có thể bàn luận hay tranh luận về vấn đề phân chia khuôn mẫu đạo đức”, nhưng vấn đề rằng machine learning có thể dựa vào những thành kiến sẵn có để đưa ra suy đoán vẫn hiện ra rõ ràng.

Người ta lo lắng rằng máy tính có thể nhầm lẫn khi phỏng đoán dựa vào những thành kiến kia: người vô tội có thể bị kết tội oan, khi mà một hệ thống gây tranh cãi như vậy được đưa vào hoạt động trong thức tế. Các nhà nghiên cứu cũng nói rằng các thuật toán của các anh cũng đã có những sự nhầm lẫn.

Bản báo cáo này nhận được vô số những ý kiến phản đối. “Tôi đã nghĩ đây là một trò đùa nhưng hóa ra bản báo cáo này là thật” hay một số người khác cho rằng việc nghiên cứu này cần những chuyên gia về tội phạm học, chuyên gia nhận dạng khuôn mặt và chuyên gia về machine learning chứ không phải vài nhà nghiên cứu nào đó nghĩ rằng chỉ cần áp dụng một khuôn mẫu có sẵn vào nghiên cứu là xong.

Những chuẩn mực đạo đức ta có sẽ không chấp nhận một kết quả như vậy. Hoặc ta hoàn thiện thuật toán và machine learning, hoặc đừng bao giờ áp dụng công nghệ này lên con người và ngoài đời thực.

Tham khảo Motherboard

NỔI BẬT TRANG CHỦ

-

2025 là một năm mà robot hình người đã có thể bước ra đời thực và khiến cả thế giới phải rùng mình

Năm 2025 đánh dấu một bước ngoặt đáng nhớ của robot hình người, khi chúng không còn chỉ đứng yên trong phòng thí nghiệm.

-

Nhóm “lưu trữ lậu” cào sạch 300TB nhạc của Spotify, tung torrent miễn phí 86 triệu bài hát