Nếu không có nghiên cứu này, các mô hình ngôn ngữ lớn với những chatbot nổi tiếng như ChatGPT, Claude, hay Gemini sẽ không thể tồn tại.

Năm 2017, tám nhà nghiên cứu tại Google Brain đã viết nên một tài liệu chỉ vỏn vẹn tám trang nhưng lại trở thành nền tảng cho toàn bộ cuộc cách mạng AI mà chúng ta đang chứng kiến ngày nay.

Bài báo mang tên "Attention Is All You Need" của Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N. Gomez, Lukasz Kaiser và Illia Polosukhin đã giới thiệu kiến trúc Transformer - xương sống của ChatGPT, Claude, Gemini và hầu hết các hệ thống AI hiện đại.

8 nhân viên Google là tác giả của nghiên cứu "Attention Is All You Need"

Trước năm 2017, AI gặp phải một vấn đề nan giải trong việc xử lý ngôn ngữ. Các mô hình khi đó hoạt động giống như một người đọc sách chỉ có thể nhớ từng từ một và quên ngay từ trước khi đọc từ tiếp theo.

Hãy tưởng tượng bạn đọc câu "Con mèo không ăn thức ăn vì nó quá no" nhưng khi đến từ "nó", bạn đã quên mất câu có nhắc đến "con mèo" hay "thức ăn". Đó chính là vấn đề mà AI phải đối mặt - không thể kết nối các từ ở xa nhau trong câu.

Nhóm tám người đã nảy ra một ý tưởng đột phá: tại sao AI phải đọc tuần tự như con người? Con người đọc từ trái sang phải vì mắt chúng ta chỉ có thể nhìn từng phần, nhưng máy tính không có giới hạn này. Thay vì xử lý từng từ một, họ đề xuất cho AI "nhìn" toàn bộ câu cùng một lúc, giống như cách chúng ta nhìn một bức ảnh hoàn chỉnh thay vì từng pixel riêng lẻ.

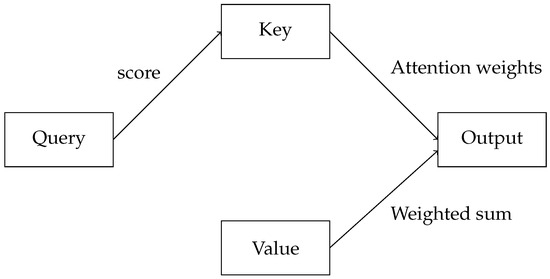

Cơ chế "chú ý" hay attention mà họ phát minh hoạt động như thế này: mỗi từ trong câu được phép "nhìn" và "tương tác" với tất cả các từ khác để hiểu ngữ cảnh. Giống như khi bạn đọc từ "nó" trong câu trên, bộ não tự động "chú ý" ngược lại để tìm xem "nó" đang nói về cái gì. Trong Transformer, mỗi từ có ba vai trò: người hỏi (Query), người trả lời (Key) và thông tin cần lấy (Value).

Hãy tưởng tượng một bữa tiệc với nhiều khách mời. Bạn là từ "nó" đang tìm kiếm ý nghĩa của mình. Bạn đưa ra câu hỏi "Tôi đang thay thế cho ai?" (Query). Mọi người trong phòng, tức các từ khác, đều giơ tay với mức độ nhiệt tình khác nhau (Key). "Con mèo" giơ tay rất cao vì biết mình liên quan, còn "thức ăn" thì ít nhiệt tình hơn. Sau đó bạn thu thập thông tin (Value) từ những người giơ tay cao nhất để hiểu rằng mình đang nói về "con mèo".

Điều thú vị là Transformer không chỉ có một cơ chế chú ý mà có tới 8 "đầu chú ý" hoạt động song song. Mỗi đầu học cách chú ý đến các khía cạnh khác nhau của ngôn ngữ. Đầu thứ nhất có thể chuyên tìm mối quan hệ chủ ngữ - động từ, đầu thứ hai theo dõi các đại từ như "nó", "họ", "chúng", đầu thứ ba nhận biết quan hệ nhân quả với các từ như "vì", "nên", "do đó". Tám đầu này cùng làm việc như một đội chuyên gia ngôn ngữ, mỗi người phụ trách một khía cạnh.

Kiến trúc hoàn chỉnh của Transformer giống như một tòa nhà 6 tầng cho phần mã hóa (encoder) và 6 tầng cho phần giải mã (decoder). Mỗi tầng đều có cơ chế chú ý và một mạng xử lý thông tin. Thông tin đi qua từng tầng, mỗi lần qua một tầng lại được tinh chỉnh và hiểu sâu hơn, giống như việc đọc đi đọc lại một đoạn văn nhiều lần để hiểu rõ hơn.

Con người xử lý ngôn ngữ tuần tự theo từng từ, nhưng máy móc lại có thể xử lý theo cách hoàn toàn khác.

Một yếu tố quan trọng khác là cách Transformer biết vị trí của từng từ. Vì xử lý tất cả các từ cùng lúc, nó cần biết từ nào đứng trước, từ nào đứng sau. Nhóm nghiên cứu giải quyết bằng cách gán cho mỗi vị trí một "mã số vị trí" độc đáo, giống như số ghế trong rạp chiếu phim, giúp AI biết thứ tự các từ trong câu.

Kết quả của phát minh này thật đáng kinh ngạc. Chất lượng dịch thuật được cải thiện vượt bậc - từ việc dịch sai nghĩa, ngữ pháp lộn xộn đến những bản dịch gần như tự nhiên. Thời gian huấn luyện giảm từ nhiều tuần xuống còn vài ngày. Trong vòng 18 tháng, hầu hết các công ty công nghệ lớn đã từ bỏ công nghệ cũ để chuyển sang Transformer.

Tuy nhiên, sức mạnh này có cái giá của nó. Khi câu càng dài, số lượng "cuộc trò chuyện" giữa các từ tăng theo cấp số nhân. Với 100 từ cần 10.000 lần tương tác, 1.000 từ cần một triệu lần. Đây là lý do tại sao ChatGPT hay Claude có giới hạn độ dài tin nhắn - chi phí tính toán tăng vọt với văn bản dài.

Hiện nay, các nhà nghiên cứu đang phát triển những kiến trúc mới như Mamba, RWKV và Mixture of Experts để khắc phục hạn chế về độ phức tạp tính toán của Transformer. Những kiến trúc này hứa hẹn xử lý nhanh hơn và có thể làm việc với văn bản dài vô hạn.

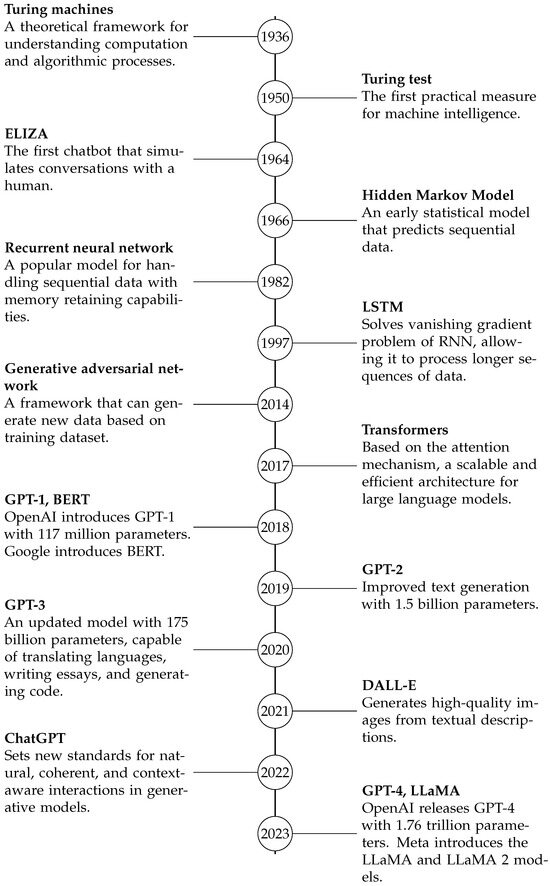

Sự thay đổi của các kiến trúc dành cho mô hình AI trong lịch sử

Transformer đã trở thành nền tảng không thể thiếu cho mọi chatbot AI hiện đại. ChatGPT được xây dựng trên GPT (Generative Pre-trained Transformer), Claude và Gemini cũng vậy. Thành công của Transformer còn lan sang xử lý hình ảnh, âm thanh và nhiều lĩnh vực khác.

Nó không chỉ là một thuật toán mà còn là cách nhìn mới về việc máy móc có thể hiểu ngôn ngữ - không cần đọc tuần tự như con người mà có thể "nhìn" toàn cảnh và nắm bắt mọi mối liên hệ phức tạp.

Câu chuyện về Transformer nhắc nhở chúng ta rằng những đột phá lớn thường đến từ việc thách thức những giả định cơ bản nhất. Tám người dám hỏi "tại sao máy tính phải đọc như con người?" đã mở ra kỷ nguyên mới của AI. Tuy nhiên giờ đây hầu hết các tác giả này đều đã rời khỏi Google.

Nhà nghiên cứu Aidan Gomez sau đó điều hành Cohere, một startup được định giá 5,5 tỷ USD. Jakob Uszkoreit xây dựng AI cho công nghệ sinh học tại Inceptive. Lukasz Kaiser đầu quân cho OpenAI, và xây dựng nên GPT-4 và o1. Niki Pamar tham gia vào Anthropic, góp phần xây dựng nên Claude. Ashish Vaswani, sáng lập nên Essential AI. Llion Jones lam việc tại Sakana AI tại Tokyo, Nhật. Illia Polosukhin quay trở lại ngành công nghiệp blockchain. Chỉ còn Noam Shazeer quay trở lại Google để lãnh đạo AI Gemini của công ty.

Trong khi nhiều tác giả đã rời Google để theo đuổi các dự án riêng, di sản họ để lại vẫn là nền tảng của mọi cuộc trò chuyện với AI mà chúng ta thực hiện mỗi ngày.

NỔI BẬT TRANG CHỦ

Vivo X300 Pro đấu iPhone 17 Pro Max: Flagship Android giá bằng 2/3 đối thủ có thực sự đáng tiền?

Với mức giá chỉ bằng hai phần ba đối thủ, Vivo X300 Pro gây bất ngờ khi sẵn sàng đối đầu trực diện với iPhone 17 Pro Max của Apple. Nhưng nếu đào sâu vào từng khía cạnh, liệu “flagship giá tốt” này có thực sự là lựa chọn thay thế xứng đáng?

iPhone Air: Người Việt chê, người Trung mê