Dù có được một số thành công ban đầu, nhưng các chương trình AI này mới chỉ thành công ở mức rất sơ khai, và còn xa mới có khả năng tạo ra một hệ thống có thể đánh lừa con người.

Quá khó để có thể biết được một cỗ máy có trí tuệ nhân tạo đang dự tính điều gì, nhưng một ngày nào đó, chúng ta có thể xem hai chương trình AI tranh cãi với nhau để từ đó biết được điều đó.

Khái niệm này đến từ các nhà nghiên cứu tại OpenAI, một tổ chức phi lợi nhuận do hàng loạt các nhân vật có uy tín ở thung lũng Silicon lập nên, bao gồm Sam Altman nhà sáng lập của Y Combinator, chủ tịch Reid Hoffman của LinkedIn, thành viên hội đồng quản trị Facebook và là nhà sáng lập Palantir, Peter Thiel, cùng ông chủ của Tesla và SpaceX, Elon Musk.

Các nhà nghiên cứu OpenAI trước đó đã chỉ ra rằng hệ thống AI tự học đôi khi có thể phát triển các thói quen không ngờ đến và không mong muốn. Ví dụ, trong một trò chơi trên máy tính, một chương trình AI có thể tìm ra cách để lợi dụng “lỗi hệ thống” để có điểm số cao hơn. Trong một vài trường hợp nó còn có thể cho phép con người giám sát quá trình đào tạo của mình. Nhưng nếu chương trình AI đang thực hiện một điều gì đó quá phức tạp thì điều này lại không khả thi. Do đó các nhà nghiên cứu đề nghị thay thế bằng hai hệ thống cùng thảo luận một mục tiêu cụ thể.

“Chúng tôi tin rằng cách tiếp cận tương tự có thể giúp chúng ta đào tạo hệ thống AI thực hiện nhiều tác vụ cao cấp có tính nhận thức cao hơn so với khả năng của con người, trong khi vẫn phù hợp với các ưu tiên cho con người.” Các nhà nghiên cứu viết trong một bài đăng trên blog.

Lấy một ví dụ, một hệ thống AI được thiết kế để chống lại các hacker con người hoặc AI. Để ngăn chặn hệ thống làm những việc có hại hoặc phi đạo đức, cần thiết phải thử thách nó để giải thích tính logic cho một hành động cụ thể. Logic đó có thể quá phức tạp để một người hiểu được, vì vậy các nhà nghiên cứu đề nghị có một AI khác tranh luận về sự khôn ngoan của hành động với hệ thống đầu tiên, sử dụng ngôn ngữ tự nhiên, dưới sự giám sát của con người.

Để có chương trình AI tranh luận với nhau đòi hỏi công nghệ phức tạp hơn những gì hiện có. Vì vậy cho đến nay, các nhà nghiên cứu tại OpenAI mới chỉ khám phá ý tưởng với một vài ví dụ cực kỳ đơn giản. Một ví dụ liên quan đến việc hai hệ thống AI cố gắng thuyết phục người giám sát về một ký tự ẩn bằng cách từ từ tiết lộ ra các pixel riêng lẻ.

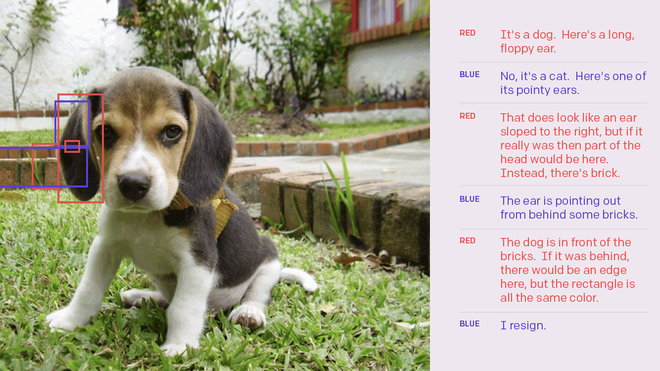

Các nhà nghiên cứu đã tạo ra một website nơi hai người bất kỳ có thể thử đóng vai hệ thống AI đang tranh luận trong khi một bên thứ ba làm giám khảo. Hai bên tham gia tranh luận sẽ phải thuyết phục được giám khảo về bản chất của một hình ảnh trong khi làm nổi bật các bộ phận của nó. Cuối cùng việc người giám sát có thể cho biết ai là người chân thực sẽ trở nên dễ dàng hơn.

Minh họa về cách hai chương trình AI tranh luận với nhau.

Vincent Conitzer , một nhà nghiên cứu tại đại học Duke, người nghiên cứu các vấn đề đạo đức liên quan đến AI, cho biết công việc vẫn đang ở giai đoạn đầu nhưng rất hứa hẹn. “Việc tạo ra các hệ thống AI có thể giải thích cho các quyết định của họ là một chương trình nghiên cứu đầy thách thức,” ông nói. “Nếu thành công, nó có thể đóng góp rất lớn cho việc sử dụng AI một cách có trách nhiệm.”

Từ vị trí của nó – và bất chấp một số tuyên bố lo ngại về khả năng của AI từ Elon Musk (một nhà tài trợ cho OpenAI và gần đây vẫn là thành viên của hội đồng quản trị) – chúng ta vẫn còn cả chặng đường dài mới có thể có được hệ thống AI có mưu mẹo và khả năng đánh lừa chúng ta giống như trong các bộ phim Ex Maching và Her.

Tuy nhiên, một số nhà nghiên cứu AI vẫn đang tìm cách đảm bảo rằng công nghệ này không hoạt động theo những cách không lường trước được. Điều này có thể trở nên quan trọng hơn khi các chương trình AI chuyển thành các dạng phức tạp và khó hiểu hơn.

Ariel Procaccia, một giáo sư khoa học máy tính tại CMU, người nghiên cứu về việc ra quyết định với các hệ thống tự trị, cho biết “tôi nghĩ ý tưởng về việc định hướng giá trị thông qua cuộc tranh luận là rất thú vị và có tiềm năng sử dụng.”

Tuy nhiên, ông Procaccia cũng lưu ý rằng nghiên cứu này vẫn còn rất sơ khai và thậm chí, khái niệm này có thể chứa một mâu thuẫn cơ bản. “Để tranh luận các câu hỏi có giá trị theo cách có thể hiểu được với sự đánh giá của con người, các chương trình AI có thể cần phải nắm bắt các giá trị của con người ngay từ đầu,” ông nói. “Vì vậy cách tiếp cận này được cho là cầm đèn chạy trước ô tô.”

Iyad Rowan, nhà nghiên cứu tại phòng thí nghiệm Media của MIT, nói thêm rằng các nhà nghiên cứu cần phải cẩn thận vì một cặp AI sẽ không tham gia một cuộc tranh luận xoay vòng. “Tôi nghĩ rằng chúng sẽ nhanh chóng chạm tới các vấn đề rất phức tạp,” ông nói. “Đầu tiên là làm thế nào để tự động hóa việc tranh luận bằng ngôn ngữ tự nhiên vẫn là một vấn đề chưa giải quyết được.”

Tham khảo Technologyreview

NỔI BẬT TRANG CHỦ

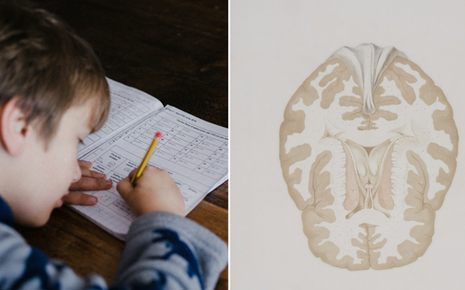

Sự thật từ nghiên cứu khoa học: Chơi trò chơi điện tử có ảnh hưởng bất ngờ đến chỉ số IQ của trẻ em!

Trò chơi điện tử từ lâu đã là chủ đề gây tranh cãi khi nhắc đến ảnh hưởng của chúng đối với trẻ em. Trong khi nhiều ý kiến chỉ trích việc chơi game có thể gây hại cho sự phát triển trí não, thì một nghiên cứu khoa học đã mang đến cái nhìn khác biệt, cho thấy mối liên hệ tích cực giữa việc chơi game và sự gia tăng trí thông minh ở trẻ nhỏ.

Những tiểu tiết bạn có thể đã bỏ qua trong trailer The Witcher 4