Hóa ra, việc tạo ra giọng nói cho các siêu máy tính hay các phần mềm, không chỉ đơn giản là tìm người để lồng tiếng là xong.

Khi máy tính lên tiếng, thì giọng nói của chúng nên giống-con-người tới mức nào?

Câu hỏi này đã từng khiến nhóm 6 chuyên gia cơ khí, ngôn ngữ và truyền thông của IBM phải "điên đầu", khi họ được giao nhiệm vụ thiết kế chức năng "biến chữ thành giọng nói" cho Watson - để siêu máy tính này có thể tham gia thi đấu trong chương trình trò chơi truyền hình "Jeopardy!".

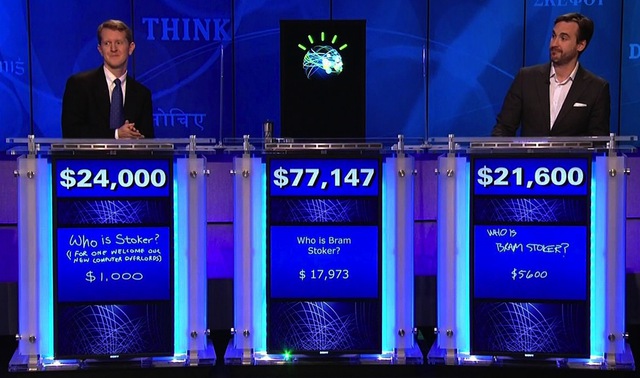

18 tháng sau, trong một chương trình đặc biệt của Jeopardy!, Watson đã đánh bại hai nhà "cựu vương" là Ken Jennings và Brad Rutter một cách vô cùng thuyết phục, bằng một giọng nói "chẳng giống con người, nhưng cũng không giống giọng của cỗ mãy HAL 9000 trong bộ phim 2001: A Space Odyssey".

Siêu máy tính Watson dễ dàng vượt qua hai "cựu vương" của chương trình Jeopardy!

Thách thức trong việc tạo ra một "nhân cách" riêng của máy móc, mà cụ thể hơn ở đây là giọng nói, đang dần được các kĩ sư tin học cũng như những nhà thiết kế phần mềm lưu tâm hơn. Nhất là khi, máy tính cùng các thiết bị thông minh khác ngày càng gọn nhẹ và phổ biến, đi kèm theo đó là tính năng tương tác bằng giọng nói, để phục vụ những người chủ "bận rộn tay chân".

Giờ đây, không chỉ có máy tính và điện thoại thông minh có khả năng nghe, hiểu và lên tiếng. Vô số các thiết bị tiện nghi khác trong cuộc siống hàng ngày cũng đã có "tiếng nói riêng", từ đồ chơi, xe ô tô, cho đến cả những Robot giúp việc trong nhà.

Vậy nên, bộ môn khoa học thiết kế mới dần xuất hiện, để đáp ứng nhu cầu tạo nên những "người bạn đồng hành" là các phần mềm với khả năng hiểu được ngôn ngữ nói, đồng thời phản hồi lại những khẩu lệnh của con người.

Tuy nhiên, việc tạo nên được một hệ thống như vậy, đối với nhà nghiên cứu lĩnh vực "tương tác con người-máy tính", vẫn là một bộ môn khoa học nghệ thuật hết đỗi khó khăn.

Hiện tại, khả năng tạo ra một giọng nói máy tính "giống hệt con người" vẫn tỏ ra khá khó khăn, nhất là với những câu thoại dài để phục vụ mục đích dự báo thời tiết hay dẫn đường cho xe cộ.

Hầu hết các nhà thiết kế phần mềm đều đồng ý rằng, họ đang phải tìm cách vượt qua "thung lũng kỳ lạ" (uncanny valley) nếu như muốn thành công. Thuật ngữ này lần đầu tiên được đưa ra vào năm 1970 bới kỹ sư Robot người Nhật Masahiro Mori, ám chỉ việc khi mà tiếng nói của máy tính tiến gần giống con người, sẽ có một giai đoạn mà âm thanh này trở nên chói tai hoặc đáng sợ. Nếu các nhà khoa học có thể băng qua được "thung lũng" này, khi đó tiếng nói của máy tính mới có thể giống hệt con người.

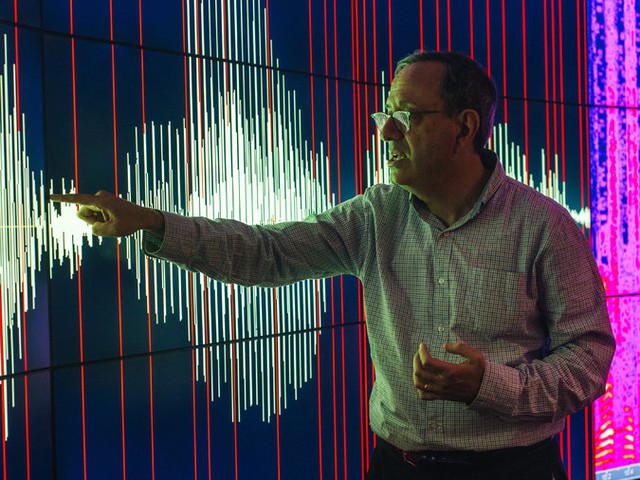

Ông Michael Picheny, hiện đang làm việc tại bộ phận nghiên cứu của IBM

Để máy tính có thể thực sự "đối thoại" cũng lại là một thử thách khác.

"Tôi cảm thấy tiếng nói của máy tính hiện tại vẫn rất chói tai" - Brian Langner, hiện đang nghiên cứu về ngôn ngữ nói tại ToyTalk, chia sẻ. Văn phòng ToyTalk đang chịu trách nhiệm cung cấp giọng nói cho rất nhiều món đồ chơi khác nhau, mà trong đó, nổi tiếng nhất là búp bê Barbie. "Con người thường có xu hướng kì vọng rằng máy tính chỉ cần làm đúng một điều, là mọi thứ khác cũng sẽ tự nhiên đúng theo."

Sau khi đạt đến ngưỡng phát âm đúng chuẩn, thử thách "khó nhằn" tiếp theo đối với các nhà khoa học là thêm vào giọng nói của máy tính những "phẩm chất con người", như âm điệu và cảm xúc. Các nhà ngôn ngữ học gọi đây là "ngôn điệu" (prosody) - tức khả năng để thêm đúng trọng âm, nhấn nhá, ngữ điệu và cảm xúc vào trong ngôn ngữ nói.

Ở thời điểm hiện tại, bất chấp tất cả những tiến bộ về mặt khoa học, việc đưa cảm xúc con người vào "giọng nói máy tính" thông qua trí tuệ nhân tạo vẫn là điều bất khả thi. Những kết quả thí nghiệm đầu tiên - sử dụng tới các thuật toán tự học của máy tính, cùng một hệ cơ sở dữ liệu khổng lồ về âm điệu của con người - mới đây vừa được công bố cho các nhà nghiên cứu ngôn ngữ.

Có nhiều phương pháp khác nhau để tạo nên "Giọng nói tổng hợp" cho máy tính. Trong số đó, phương pháp cho ra kết quả chất lượng nhất sử dụng tới các "diễn viên lồng tiếng". Những người này sẽ nói những từ ngữ và các thành phần cơ bản của câu để tạo thành một "bộ cơ sở dữ liệu tiếng nói". Thông thường một diễn viên lồng tiếng sẽ phải nói từ hàng chục, đến hàng trăm giờ cho mỗi bộ âm thanh khác nhau.

Năm 2013, các nhà làm phim đã tập trung khai thác tầm quan trọng của cảm xúc trong giọng nói máy tính, thông qua bộ phim khoa học viễn tưởng "Her". Trong phim, chàng nhân viên công sở do Joaquin Phoenix thủ vai, đã trót phải lòng Samantha - giọng nói nhân tạo của một hệ điều hành tân tiến.

Giọng nói của Samantha được lồng tiếng bởi Scarlett Johanson, do đạo diễn Spike Jonze cảm thấy nữ diễn viên đầu tiên nhận vai diễn này không đủ khả năng để truyền tải tới khán giả chuyện tình lãng mạn giữa con người và máy móc.

her - câu chuyện tình giữa con người và "giọng nói" của một hệ điều hành

Câu chuyện về giọng nói của máy tính, bắt đầu từ những nghiên cứu đầu tiên của kỹ sư tin học Alan Black - người mà hiện tại đang là giáo sư tại Viện Công nghệ Ngôn ngữ thuộc trường Đại học Carnegie Mellon.

Theo như ông Black, mặc dù từ thời điểm ông bắt đầu nghiên cứu tới nay, đã có rất nhiều thành tựu to lớn mà các nhà khoa học đạt được trong lĩnh vực này, nhưng giọng nói của máy tính vẫn còn cách sự hoàn thiện rất, rất xa. "Vấn đề của chúng ta hiện tại là chúng ta vẫn chưa có phương pháp tương tác hoàn hảo đối với các cỗ máy. Nếu nói với chúng rằng 'Nói câu này, tình cảm vào nhé', nghe chừng có vẻ không được hợp lý cho lắm".

Đối với đội ngũ phát triển tại ToyTalk, khi thiết kế các nhân vật giải trí, họ sẽ không phải quá lưu tâm đến những sai sót - bởi lẽ mục tiêu sau cùng của sản phẩm là "mua vui" cho khách hàng. Tuy nhiên, đối với các phần mềm và thiết bị nhằm mục đích tương tác với con người trong các tình huống thương mại, hoặc làm bạn đồng hành, thì đây lại là vấn đề khác hoàn toàn.

Các nhà thiết kế hoạt động trong lĩnh vực này hiện tại vừa không muốn đánh lừa con người rằng họ đang giao tiếp với máy móc, nhưng cũng vừa muốn mối quan hệ giữa máy tính và người sử dụng giống-con-người nhất có thể.

Mới đây, IBM có chạy một chương trình quảng cáo trên truyền hình, với nội dung là một cuộc đối thoại giữa ca sĩ - nhạc sĩ nổi tiếng Bob Dylan và siêu máy tính Watson. Và khi Watson cất tiếng hát, ngài Dylan ngay lập tức rời khỏi sân khấu, bởi lẽ siêu máy tính này hát quá tệ.

Quảng cáo này được thực hiện nhằm mục đích chứng tỏ rằng Watson không quá giống con người. Thứ mà IBM tìm kiếm, là một giọng nói "khác người", nhưng không đáng sợ.

Việc tạo ra giọng nói cho siêu máy tính Watson để thi đấu trong chương trình "Jeopardy!" là một thử thách khá "khó nhằn" đối với các nhà nghiên cứu tại IBM. Bởi lẽ tuy các câu trả lời mà máy tính cần phải đưa ra rất ngắn, nhưng chỉ Watson cần phát âm sai, hoặc "nói ngọng", thì ngay lập tức sẽ trở thành "thảm họa".

"Phát âm sai là vấn đề khiến cho nhóm nghiên cứu của chúng tôi đau đầu nhất" - ông Andy Aaron chia sẻ

"Sai số trong việc phát âm chuẩn xác các từ, chính là vấn đề đau đầu nhất đối với nhóm nghiên cứu" - ông Andy Aaron, hiện đang nghiên cứu tại Phòng Môi trường Giao tiếp của IBM, chia sẻ.

Các thành viên trong nhóm nghiên cứu mất hơn một năm để tạo ra một thư viện phát âm khổng lồ cho Watson, với mục tiêu đưa sai số về gần 0 nhất có thể. Đặc biệt là đối với những cụm từ khó như "brut Champagne", "carpe diem", hay "sotto voce" - khi chúng được phát âm khác với quy tắc thông thường.

Tiếp đến, nhóm nghiên cứu phỏng vấn 25 diễn viên lồng tiếng khác nhau, để tìm ra được giọng nói mà họ cảm thấy ưng ý nhất. Giọng nói này sẽ được tùy biến theo nhiều cách khác nhau, nhằm mục đích chọn giọng nói phù hợp cho Watson. Thậm chí, nhóm nghiên cứu còn đẩy cao độ âm thanh lên, khiến cho giọng nói của Watson nghe giống hệt một đứa trẻ con.

"Nghe đến đây, ai ai cũng lắc đầu quầy quậy" - ông Michael Picheny đến từ trung tâm nghiên cứu của IBM chia sẻ. "Chúng tôi không muốn giọng nói của Watson nghe có vẻ nhiệt tình thái quá".

Chất giọng mà nhóm nghiên cứu hướng đến cần phải "từ tốn, chắc chắn, và quan trọng nhất, là dễ nghe". Giống như nhưng người nghệ sĩ, công việc cuối cùng mà họ cần làm là hiệu chỉnh lại âm thanh để tạo nên sản phẩm cuối cùng. Và đây là kết quả mà nhóm nghiên cứu thu được - một giọng nói của máy tính, nhưng có chất lạc quan, hăng hái trong đó.

"Đối với chúng tôi, giao diện máy tính-máy móc đẹp là một tác phẩm nghệ thuật. Chúng nên được mọi người coi như vậy", ông Picheny chia sẻ.

Khi công nghệ phát triển giọng nói nhân tạo tiếp tục được cải thiện, sẽ có những ứng dụng mới, phức tạp hơn, cũng như có phần "lộn xộn" hơn.

Công ty phần mềm Imperson, có trụ sở đặt tại Israel, vốn được biết đến nhờ việc tạo ra các "nhân vật tương tác" trong ngành giải trí. Hiện tại, công ty này đang có ý định "lấn sân" sang lĩnh vực chính trị, với ý tưởng rằng vào thời gian tranh cử, các chính trị gia có thể đưa ra các "nhân vật ảo" trên các trang mạng xã hội để tương tác với mọi người. Thông qua đó, những nhân vật sở hữu giọng nói của Ted Cruz, hay Donald Trump có thể giải đáp thắc mắc về mọi chủ đề, mọi lúc, mọi nơi.

"Mọi người luôn muốn có những cuộc đối thoại trực tiếp với các ứng viên," ông Eyal Pfeifel, người đồng sáng lập nên Imperson cho biết. "Mọi người sẽ hiểu, và qua đó, những vấn đề như thung lũng kỳ lạ sẽ không còn tồn tại nữa".

Tham khảo nytimes

NỔI BẬT TRANG CHỦ

Nhà sáng lập TSMC nhận định về Intel: Sẽ tốt hơn nếu không cố chen chân vào mảng sản xuất chip, đáng lẽ nên tập trung vào AI

Morris Chang, nhà sáng lập TSMC, đã thẳng thắn nhận định chiến lược kinh doanh của Intel, cho rằng "Đội Xanh" đáng lẽ không nên bước chân vào lĩnh vực sản xuất chip và thay vào đó nên tập trung vào thị trường AI.

Chủ tịch Huawei tự hào khoe Mate 70 là điện thoại với chip 100% Made in China: "Tự chủ ngành bán dẫn đã trở thành hiện thực"