Autopilot và các công nghệ khác của Tesla thực sự là cứu cánh cho tương lai của con người. Ve là Tesla sẽ phải tìm cách để giải thích điều đó với loài người mù công nghệ.

Tháng 7 quả là một tháng đen tối với Tesla. Sau khi thông tin về vụ tai nạn chết người đầu tiên do một chiếc Model S ở chế độ tự lái (Autopilot) gây ra, công ty của tỷ phú Elon Musk liên tục bị "đánh hội đồng" bởi các tờ báo lớn như Fortune và Consumer Reports. Trong cùng một tháng, một số vụ tai nạn khác lại tiếp tục xảy ra và Autopilot tiếp tục bị quy kết trách nhiệm.

Khi ghé thăm trang Twitter của Elon Musk, bạn sẽ nhận thấy vị tỷ phú này dường như đang phải đặt mạng xã hội của mình ở chế độ "phòng thủ". Số lượng tweet mang màu sắc gượng gạo chống đỡ lại các cáo buộc, các thông tin tiêu cực từ các nguồn tin là quá lớn.

Nhưng vấn đề của Tesla không phải là Autopilot. Vấn đề của Tesla là thế giới quá mù công nghệ.

Elon Musk đã có thời là coder, và cách hoạt động của Tesla cũng giống với startup phần mềm hơn là nhà sản xuất xe hơi.

Chúng tôi đã có bài viết khẳng định rằng nếu nhìn từ góc độ hệ thống, việc những chiếc xe tự lái gặp tai nạn chết người là chuyện tất yếu, không sớm thì muộn cũng sẽ phải xảy ra. Người thực sự hiểu biết về công nghệ sẽ chấp nhận sự thật rằng không có hệ thống nào là không có lỗi, không ít thì nhiều. Thậm chí, có những "lỗi" không phải là... lỗi theo ý hiểu thông thường (có sai sót, có sự thiếu cẩn thận từ phía người thực hiện hệ thống) mà chỉ là các trường hợp hệ thống không hoạt động theo đúng với cách hiểu và kỳ vọng của người dùng.

Với Autopilot, cả 2 loại lỗi này đều tồn tại, nhưng với bản chất là một hệ thống mới mẻ, chắc chắn loại lỗi thứ 2 (không đúng với cách hiểu của người dùng) cũng chiếm một tỷ lệ không hề nhỏ. Đây cũng là lý do vì sao Tesla đã không ít lần nhấn mạnh trong các vụ tai nạn do Autopilot gây ra rằng "giáo dục người dùng" là cực kỳ quan trọng để giảm thiểu các sự cố có liên quan tới tính năng này. Cũng giống như các hệ thống "autopilot" trên máy bay, Autopilot của Tesla chỉ có tác dụng hỗ trợ thay vì là một hệ thống có khả năng hoạt động hoàn toàn độc lập, không cần có con người.

Vấn đề là người dùng không sẵn sàng hiểu điều này. Trong khi gần như tất cả các tuyên bố từ phía Tesla cũng như thỏa thuận người dùng EULA lúc nào cũng nhấn mạnh "Autopilot không hủy bỏ trách nhiệm điều khiển của lái xe đối với chiếc xe" thì người dùng sẵn sàng xem Harry Potter, ngủ, đánh bài và ngồi ghế sau để mặc kệ cho Autopilot thích làm gì thì làm. Bất kể Tesla có nói gì, những người chủ Model S và Model X đang kỳ vọng quá nhiều vào Autopilot. Trong phạm vi hiểu biết của họ, Autopilot không được có lỗi.

Đó là một kịch bản hoàn toàn viễn tưởng, tuyệt đối không thể xảy ra. 10 năm nữa, (nếu Tesla vẫn tồn tại) Autopilot vẫn sẽ có lỗi. Nhưng những người "mù" công nghệ thì sẽ không thể thấm thía điều này như những người làm công nghệ. Bạn có biết rằng coder nào dám khẳng định "Code tôi không có lỗi" đều sẽ bị những người xung quanh nhìn một cách... đầy coi thường, bởi chỉ có những người thiếu kinh nghiệm mới dám to mồm khẳng định như vậy.

Ngay cả các hệ thống tàu vũ trụ cũng thế. Đó là những hệ thống xây dựng bởi những kỹ sư ưu tú nhất của nhân loại, mang theo những con người ưu tú nhất của nhân loại đi thảm hiểm không trung trong những chuyến đi hàng chục, hàng trăm triệu đô. Ấy vậy mà những vụ nổ tàu vũ trụ vẫn xảy ra quá nhiều lần.

Nói như vậy không có nghĩa rằng ai đó được nói "Người dùng ngớ ngẩn là nguyên nhân của tất cả các sự cố". Nhưng để có cái nhìn công bằng nhất, chúng ta phải nhìn ra một sự thật quan trọng rằng: một vụ tai nạn đơn lẻ không thể dùng để đưa ra đánh giá cuối cùng về một hệ thống máy móc, vốn chắc chắn có độ ổn định và an toàn vượt trội so với con người.

Tai nạn chết người của Model S khi Autopilot đang cầm lái.

Thậm chí, nếu như có 10 vụ tai nạn chết người xảy ra thì Autopilot và các hệ thống tự lái khác vẫn sẽ là phần tất yếu của tương lai. Lý do là bởi các hệ thống này sẽ luôn được tiếp tục "nạp" các nguồn dữ liệu khổng lồ để ngày một nhận diện đường đi tốt đẹp hơn. Bất cứ một hệ thống phần cứng và phần mềm nào cũng vậy. Càng hoạt động nhiều, càng dễ phát hiện lỗi. Phát hiện lỗi rồi sửa, hệ thống càng hoàn thiện. Đây là quy luật tất yếu, hiển nhiên và cũng là tôn chỉ hoạt động của các ngành kỹ nghệ kỹ thuật.

Nhưng loài người nói chung thì không thể hiểu được điều đó. Trái lại, họ còn không hiểu ý nghĩa của công nghệ mà họ đang "ném đá" kịch liệt. Mới đây, Consumer Reports đã đưa ra đề xuất rằng Tesla hãy "Tắt Autopilot cho tới khi tính năng này được lập trình để bắt buộc phải đặt tay trên vô lăng mọi lúc". Đề xuất này có thể gói gọn trong hai chữ "ngớ ngẩn", bởi người dùng lúc nào cũng đặt tay trên vô lăng thì "tự lái" có nghĩa lý gì?

Tiếp đến, kể cả Tesla có thể "lập trình" theo kiểu nào đó để đảm bảo người dùng buộc phải đặt tay lên vô lăng để có thể kích hoạt Autopilot thì chắc chắn vẫn sẽ có người tìm ra cách để lách luật. Thái độ vô trách nhiệm của con người với mạng lái của mình khi cầm lái là không thể bàn cãi.

Thậm chí, nhiều người còn "lầy lội" tới mức sẵn sàng đổ lỗi cho Autopilot ngay cả khi họ không hề bật tính năng này. Từ đầu năm tới nay, báo chí đã đăng tải ít nhất là 3 vụ tai nạn do chính con người gây ra nhưng lại bị đổ cho Autopilot. Bằng chứng được Tesla cung cấp từ "hộp đen" trên xe trong các vụ việc này đã chứng minh 1 sự thật đáng buồn: nếu có điều kiện, rất nhiều người người sẽ thoái thác trách nhiệm cho các đối tượng khác.

Một trong số rất nhiều các vụ tai nạn bị con người đổ thừa cho Autopilot trong khi chính họ là thủ phạm.

Máy móc thì khác. Chúng không có khái niệm "trách nhiệm" mà chỉ có khái niệm "tính năng". Các tính năng được thực thi bởi các kỹ sư có học vấn, có trách nhiệm của Tesla, Volvo và các nhà sản xuất khác - nói cách khác, đến một ngày Tesla hủy bỏ yêu cầu "người lái phải chịu trách nhiệm cho Autopilot" thì bạn sẽ đặt tính mạng của mình và tay các kỹ sư của Tesla. Nếu phải lựa chọn giữa các kỹ sư của Tesla và một tay lái say xỉn hoặc mệt mỏi ngủ gật nào đó, chắc chắn bạn nên lựa chọn phương án thứ nhất.

Cuối cùng và quan trọng nhất, trách nhiệm của Elon Musk và của Tesla dừng ở mức nào? Văn bản thỏa thuận sử dụng cho phần mềm EULA đã quy định rõ trách nhiệm của người lái và của Tesla, mỗi lần xuất hiện trên mặt báo cả Elon Musk lẫn các đại diện khác của công ty cũng nhắc đi nhắc lại rằng Autopilot không phải là giải pháp tự động hoàn toàn và cũng không phải là lý do để lái xe thoái thác hết trách nhiệm với mạng sống của chính mình.

Điều này có thể ví với các loại hóa chất có thể gây nguy hiểm: nhà sản xuất làm hết trách nhiệm thì cũng chỉ có thể cảnh báo với bạn về các tác hại có thể gây ra, còn bạn vẫn phải có trách nhiệm với hành động của chính mình khi đang sử dụng những vật thể đòi hỏi sự cẩn thận tuyệt đối, bất kể đó là một con dao sắc nhọn, một chai thuốc trừ sâu hay một chiếc xe tự lái.

NỔI BẬT TRANG CHỦ

-

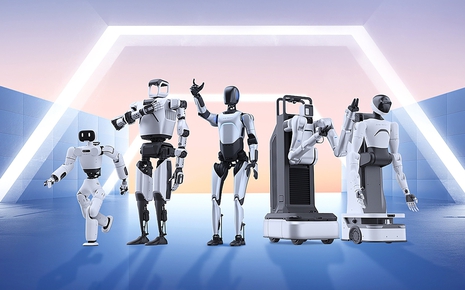

Robot hình người Trung Quốc áp đảo CES 2026, hé lộ cuộc đua quyền lực mới của AI toàn cầu

CES 2026 chứng kiến một bức tranh khác thường khi hơn một nửa các gian hàng robot hình người đến từ Trung Quốc, phản ánh rõ tham vọng chiếm lĩnh lĩnh vực được xem là giao điểm then chốt giữa trí tuệ nhân tạo và sản xuất tiên tiến.

-

Thiết bị kỳ lạ của HP: Máy tính All-In-One hay bàn phím văn phòng?