Một nhóm các nhà nghiên cứu quốc tế mới đây đã thành công trong việc dạy AI biện hộ cho lập luận của nó, cũng như chỉ ra các luận cứ mà nó dựa vào đó để đưa ra một quyết định. Chiếc hộp đen mà chúng ta thường thấy đang ngày một trở nên rõ ràng hơn.

Từ trước đến nay, việc tìm ra lý do tại sao một mạng thần kinh đưa ra các quyết định cụ thể luôn là một trong những mối quan tâm hàng đầu trong lĩnh vực trí tuệ nhân tạo. Người ta gọi nó là "vấn đề hộp đen", và đây cũng chính là nguyên nhân hàng đầu khiến con người chưa thể đặt niềm tin hoàn toàn vào các hệ thống AI được.

Nhóm nghiên cứu này là một tập hợp các nhà nghiên cứu đến từ UC Berkeley, Đại học Amsterdam, Viện nghiên cứu Max Planck về Tin học, và Đội nghiên cứu AI của Facebook. Đề tài nghiên cứu mới này được xây dựng trên nền tảng một nghiên cứu trước đó cũng của nhóm, nhưng lần này, họ đã "dạy" cho AI một số "trò" mới.

Giống như con người, AI có thể "chỉ ra" luận cứ mà nó đã sử dụng để trả lời một câu hỏi nào đó, và thông qua văn bản, nó có thể miêu tả lại rằng mình đã diễn giải luận cứ đó như thế nào. AI này được phát triển để có thể trả lời các câu hỏi đòi hỏi trí thông minh trung bình của một em bé 9 tuổi.

Theo báo cáo đã được xuất bản mới đây của nhóm nghiên cứu thì đây là lần đầu tiên con người tạo ra được một hệ thống có thể tự giải thích cho chính bản thân mình theo hai cách khác nhau:

"Mô hình của chúng tôi là mô hình đầu tiên có khả năng đưa ra các lời biện hộ cho các quyết định của nó theo ngôn ngữ nói tự nhiên, cũng như có thể chỉ ra các luận cứ trong một hình ảnh".

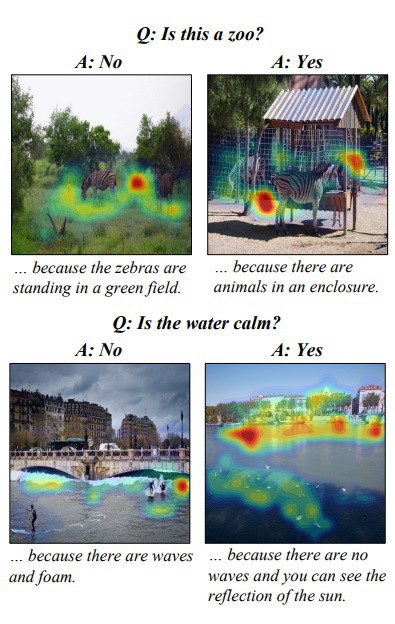

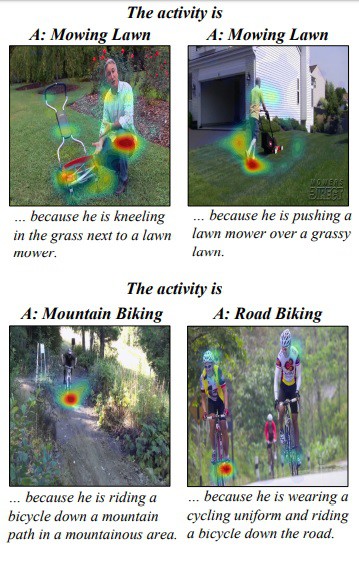

Các nhà nghiên cứu đã phát triển AI này để nó có thể trả lời các câu hỏi được đặt ra theo ngôn ngữ thông thường về các hình ảnh. Nó có thể trả lời các câu hỏi về các chủ thể và hành động trong một khung cảnh được cung cấp. Và nó còn giải thích câu trả lời của mình bằng các miêu tả những gì nó thấy, đồng thời làm nổi bật những phần liên quan đến câu trả lời của mình trong bức hình. Các bạn có thể xem minh hoạ bên dưới để hiểu rõ hơn:

Tất nhiên, là một cỗ máy, nó cũng có lúc trả lời sai. Trong các bài thử nghiệm, AI đã gặp khó khăn khi xác định liệu một người có đang cười hay không, và nó cũng không thể nêu ra điểm khác biệt giữa một người đang sơn phòng và một người đang sử dụng máy hút bụi.

Nhưng đó lại chính là mấu chốt của vấn đề: khi một cỗ máy gặp sai sót, chúng ta cần phải biết lý do tại sao nó đưa ra quyết định sai lầm.

Để lĩnh vực AI có thể đạt được mức độ cảm thụ như con người, chúng ta sẽ cần các phương thức để gỡ lỗi, kiểm tra lỗi, và hiểu quá trình đưa ra các quyết định của máy móc. Điều này đặc biệt cấp thiết trong bối cảnh các mạng thần kinh đang ngày một tiên tiến hơn và trở thành nguồn phân tích dữ liệu chính của chúng ta.

Việc tạo ra một phương thức để AI có thể biểu đạt hoạt động của nó và tự biện hộ cho chính bản thân nó theo những cách mà ngay cả những người không có kiến thức chuyên môn cũng có thể hiểu được thực sự là một bước tiến lớn trong việc ngăn ngừa một thảm hoạ diệt chủng do robot gây ra - một viễn cảnh đáng sợ mà mọi người đều đang rất lo lắng khi chứng kiến sự phát triển thần tốc của AI.

Tham khảo: TheNextWeb

NỔI BẬT TRANG CHỦ

-

Cuối cùng Google cũng cho đổi địa chỉ Gmail mà không phải tạo tài khoản mới, ai dùng mail từ thời “trẻ trâu” chắc mừng lắm

Một thay đổi được chờ đợi từ lâu khi người dùng Gmail có thể đổi địa chỉ email mà không cần tạo tài khoản mới.

-

Giá RAM tăng quá cao, ASUS cân nhắc tự sản xuất DRAM từ 2026