Gót chân Achilles của trí tuệ nhân tạo, AI không hề toàn năng như mọi người vẫn nghĩ

Vào cuối thế kỷ 20, nhà toán học Steve Smale đã đưa ra danh sách 18 bài toán chưa giải được, bài cuối cùng đề cập đến giới hạn trí thông minh của con người và máy móc.

- Loại vật liệu mới này sẽ giúp cho chúng ta thắp sáng ngôi nhà mà không cần dùng tới điện

- NASA đã tìm thấy 20 hành tinh đầy hứa hẹn cho con người sinh sống

- Liệu rằng mặt trăng có thể va vào Trái Đất như trong phim Moonfall hay không?

- Azuma Makoto, người tiên phong trong dự án đưa cây ra ngoài vũ trụ

- Nghiên cứu mới cho thấy khủng long cũng bị "cảm lạnh"!

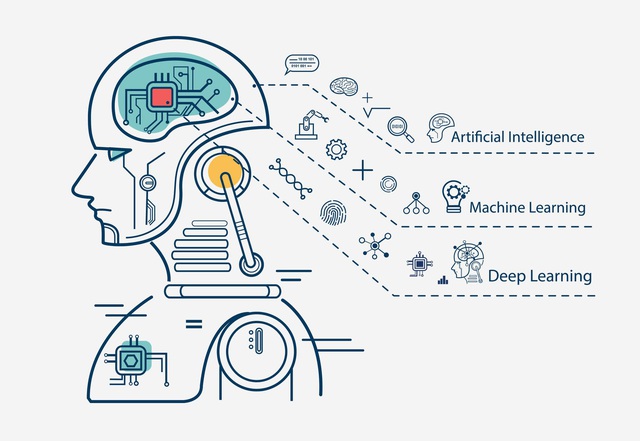

Học sâu (deep learning) là một kỹ thuật trí tuệ nhân tạo để nhận dạng mẫu, một kỹ thuật thành công đang thâm nhập vào lĩnh vực máy tính khoa học. Chúng ta thường thấy nó trong nhiều tiêu đề tin tức nổi tiếng như khả năng chẩn đoán bệnh chính xác hơn bác sĩ, hay khả năng ngăn ngừa tai nạn giao thông nhờ tính năng lái xe tự động. Tuy nhiên, có một thực tế là rất nhiều hệ thống học sâu không đáng tin cậy và chúng dễ bị đánh lừa.

Điều này khiến các hệ thống AI giống như một số con người quá tự tin, thường có sự tự tin vượt xa khả năng thực tế của chúng. Trong khi con người tương đối giỏi trong việc phát hiện ra sai lầm của chính mình, thì nhiều AI lại không có cách nào để biết khi nào chúng mắc lỗi. Đôi khi, hệ thống AI thậm chí còn khó nhận ra khi nó mắc lỗi hơn là tạo ra kết quả chính xác.

Các nhà nghiên cứu từ Đại học Cambridge và Đại học Oslo nói rằng sự bất ổn định này chính là gót chân Achilles của AI hiện đại, và rằng một nghịch lý toán học cho thấy những hạn chế của AI. Nghịch lý này có thể bắt nguồn từ hai nhà toán học vĩ đại của thế kỷ 20, Alan Turing và Kurt Gödel. Vào đầu thế kỷ 20, các nhà toán học đang cố gắng chứng minh rằng toán học là ngôn ngữ cuối cùng để thống nhất khoa học. Tuy nhiên, Turing và Gödel đã phát hiện ra một nghịch lý ở trung tâm của toán học: chân lý của một số mệnh đề toán học nhất định không thể được chứng minh và một số vấn đề tính toán không thể được giải quyết bằng các thuật toán.

Vào cuối thế kỷ 20, nhà toán học Steve Smale đã đưa ra danh sách 18 bài toán chưa giải được, bài cuối cùng đề cập đến giới hạn trí thông minh của con người và máy móc. Vấn đề này cho tới nay vẫn chưa được giải quyết, nhưng nó mang đến cho thế giới trí tuệ nhân tạo một nghịch lý lần đầu tiên được đặt ra bởi Turing và Gödel: toán học có những giới hạn cơ bản cố hữu, và tương tự, các thuật toán trí tuệ nhân tạo cũng có những vấn đề không thể giải quyết được.

Một nghiên cứu mới cho thấy trí thông minh nhân tạo có mặt ở khắp mọi nơi với những giới hạn cố hữu có thể là nguyên nhân dẫn đến nghịch lý toán học kéo dài hàng thế kỷ này. Bằng cách mở rộng cách tiếp cận do Gödel và Turing đề xuất, các nhà nghiên cứu đã chỉ ra giới hạn của các thuật toán đối với mạng nơ-ron tính toán. Họ đề xuất một lý thuyết phân loại mô tả cách thức, trong những điều kiện nhất định, một mạng nơ-ron có thể được đào tạo để cung cấp một hệ thống AI đáng tin cậy.

Mạng nơ-ron là công cụ tiên tiến nhất trong lĩnh vực trí tuệ nhân tạo, chúng là sự mô phỏng thô các kết nối giữa các nơ-ron trong não. Trong nghiên cứu mới, các nhà nghiên cứu nói rằng trong khi các mạng nơ-ron tốt có thể tồn tại trong một số trường hợp, thì chúng ta không thể tạo ra một mạng nơ-ron vốn đáng tin cậy vì nghịch lý này. Nói cách khác, cho dù dữ liệu chúng ta sử dụng để xây dựng mạng nơ-ron chính xác đến đâu, thì chúng ta cũng không bao giờ có thể có được thông tin hoàn hảo cần thiết để xây dựng mạng nơ-ron hoàn hảo 100%.

Đồng thời, không thể tính toán một mạng nơ-ron hiện có tốt đến đâu, cho dù nó được đào tạo thông qua nhiều dữ liệu. Bất kể thuật toán có quyền truy cập vào bao nhiêu dữ liệu, nó sẽ không bao giờ tạo ra mạng mà nó cần. Điều này tương tự với quan điểm của Turing: có những vấn đề tính toán không thể được giải quyết bất kể sức mạnh tính toán và thời gian chạy.

Các nhà nghiên cứu cho biết, không phải tất cả trí thông minh nhân tạo đều có sai sót. Trong một số trường hợp, nó chỉ đáng tin cậy trong các lĩnh vực cụ thể, sử dụng các phương pháp cụ thể. Tuy nhiên, đây không phải là những gì chúng ta thấy trong nhiều hệ thống.

Tiến sĩ Matthew Colbrook từ Khoa Toán học Ứng dụng và Vật lý Lý thuyết cho biết: "Trong một số tình huống AI mắc lỗi là hoàn toàn ổn, nhưng nó cần phải trung thực về điều đó. Và đó không phải là những gì chúng ta đang thấy đối với nhiều hệ thống - không có cách nào để biết khi nào chúng tự tin hơn hay kém tự tin hơn về một quyết định".

Giáo sư Anders Hansen từ Khoa Toán ứng dụng và Vật lý lý thuyết của Cambridge cho biết: "Hiện tại, các hệ thống AI đôi khi có thể đoán được. Nhưng đến một lúc nào đó, bạn sẽ cảm thấy mệt mỏi vì không đạt được điều mình muốn, và bạn sẽ thử một phương pháp khác. Điều quan trọng là phải hiểu những hạn chế của các cách tiếp cận khác nhau. Chúng ta đang ở giai đoạn mà những thành công thực tế của AI vượt xa lý thuyết và sự hiểu biết. Cần có một chương trình tìm hiểu nền tảng của điện toán AI để thu hẹp khoảng cách này".

"Khi các nhà toán học thế kỷ 20 xác định được những nghịch lý khác nhau, họ đã không ngừng nghiên cứu toán học. Họ đã cố gắng tìm ra những con đường mới, bởi vì họ hiểu những hạn chế", Colbrook nói. "Đối với AI, đó có thể là trường hợp thay đổi đường dẫn hoặc phát triển con đường mới để xây dựng các hệ thống có thể giải quyết vấn đề một cách đáng tin cậy và minh bạch, đồng thời hiểu được những hạn chế của chúng".

Giai đoạn tiếp theo của các nhà nghiên cứu là kết hợp lý thuyết xấp xỉ, phân tích số và cơ sở tính toán để xác định mạng nơ-ron nào có thể được tính toán bằng các thuật toán và mạng nào có thể ổn định và đáng tin cậy. Cũng giống như những nghịch lý về giới hạn của toán học và máy tính được Gödel và Turing xác định đã dẫn đến những lý thuyết nền tảng phong phú - mô tả cả những giới hạn và khả năng của toán học và tính toán.

NỔI BẬT TRANG CHỦ

-

Smartphone "quốc dân" REDMI Note 15 series vừa chính thức ra mắt: Có Chi Pu làm đại sứ, lần đầu tiên có tính năng cực thiết thực này, giá từ 6 triệu nhưng mua sale rẻ hơn

REDMI Note 15 Series chính thức trình làng tại Việt Nam, trang bị camera 200 MP, chuẩn bền mới, sạc nhanh 100W và giá từ 5,99 triệu đồng.

-

Trải nghiệm Corsair Sabre v2 Pro Wireless MG: Khung magie "lộ xương”, siêu nhẹ chỉ 56g nhưng mang đến mọi thứ game thủ chuyên nghiệp cần