Poll: Khảo sát phản ứng người dùng khi Apple tuyên bố sẽ "soi" album ảnh trên iPhone, iPad..

Trong phiên bản iOS và iPadOS sắp tới, Apple sẽ bổ sung thêm tính năng quét hình ảnh có trên thiết bị của người dùng nhằm ngăn chặn các hành vi lạm dụng tình dục trẻ em. Phản ứng của người dùng iPhone lúc này ra sao?

- Poll: Bán kết Đại chiến "Thế giới di động" - Hãng điện thoại nào sẽ đi đến trận cuối cùng, tất cả nằm trong tay bạn quyết định!

- Poll: Vòng bảng Đại chiến "Thế giới di động": Các bạn là người chọn ra những cái tên xuất sắc nhất!

- Quiz: Sao Hoả và hành trình chinh phục “Hành tinh Đỏ” của nhân loại

- Quiz Lan man 01: Thử thách sự hiểu biết của bạn về thế giới xung quanh!

- Quiz: Dùng máy tính gần 30 mùa xuân rồi, vậy thách bạn trả lời đúng hết về chip máy tính Intel!

- Quiz: Mảnh ghép logo thuộc về ai? Chỉ có 2% người chơi trên thế giới nhận ra

Vào ngày 5/8 vừa qua, Apple đã công bố một tính năng mới trong gói cập nhật phiên bản iOS 15. Họ nói rằng thông qua tính năng này phân tích ảnh trên iPhone để tìm ra những hình ảnh bất hợp pháp và bị cấm nhằm bảo vệ trẻ em và cha mẹ của chúng trong quá trình sử dụng iPhone và iPad. Đây cũng tính năng gây tranh cãi trong tuần vừa qua.

Cụ thế, iOS 15 sẽ có thuật toán NeuralHash để phát hiện lạm dụng trẻ em trong ảnh và video (CSAM). Quy trình quét sẽ kiểm tra xem các hình ảnh được người dùng tải lên kho lưu trữ iCloud có hình ảnh nào khớp với bất kỳ hình ảnh đã được đánh dấu trong cơ sở dữ liệu về các nội dung lạm dụng tình dục đã được biết hay không. Apple sẽ chỉ có thể giải mã và xem các hình ảnh trên iCloud nếu tài khoản đó có số lượng ảnh bị nghi ngờ chứa nội dung lạm dụng tình dục trẻ em vượt qua một "ngưỡng" nhất định.

Nếu số lượng ảnh bị nghi ngờ vi phạm trên tài khoản iCloud của người dùng vượt qua "ngưỡng giới hạn", Apple sẽ xem xét thủ công các nội dung bị nghi ngờ vi phạm, vô hiệu hóa tài khoản iCloud của người dùng và gửi báo cáo tới Trung tâm Quốc gia về Trẻ em mất tích và Bị bóc lột (NCMEC). Nhà nghiên cứu bảo mật Matthew Green của Đại học Johns Hopkins gọi CSAM là "một ý tưởng rất tồi". "Tôi không ủng hộ việc lạm dụng hoặc khủng bố trẻ em. Nhưng tôi tin rằng mọi người dùng nên chắc chắn rằng nội dung trên thiết bị của mình vẫn an toàn và không đi đâu cả.", ông Green nói.

Alec Buffett, cũng là một nhà nghiên cứu bảo mật trước đây từng làm việc tại Facebook, coi việc giới thiệu CSAM và thuật toán quét hình ảnh NeuralHash là "một bước lùi lớn về mặt quyền riêng tư". Cũng có thêm một vài chuyên gia bảo mật khác cũng lo ngại rằng tính năng mới của Apple chỉ là một cách đặt "cửa hậu" trên iCloud để có thể giám sát người dùng. Chẳng hạn, mục đích hiện tại của tính năng này là để quét và tìm những hình ảnh lạm dụng tình dục trẻ em, tuy nhiên, trong tương lai, Apple hoàn toàn có thể thay đổi chức năng chính của tính năng này để có thể quét và tìm những nội dung hình ảnh khác mà người dùng không hay biết.

Hiện tại các tính năng hạn chế và ngăn chặn nội dung khiêu dâm trẻ em sẽ được áp dụng đối với người dùng tại Mỹ. Liệu bạn có sẵn sàng để Apple quét ảnh trong máy của bạn không? Hãy cho chúng mình biết ý kiến của bạn về tính năng mới này của Apple nhé.

Theo: Macrumors

NỔI BẬT TRANG CHỦ

-

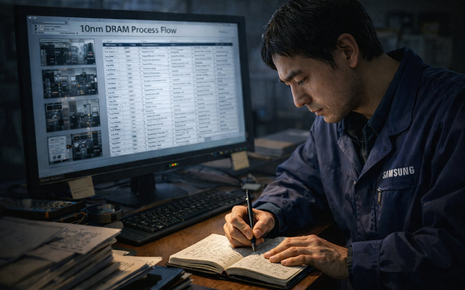

Không USB, không email, làm thế nào nhân viên Samsung tuồn quy trình 600 bước của công nghệ DRAM 10nm sang Trung Quốc?

Dù được bảo vệ nghiêm ngặt bằng nhiều thiết bị giám sát điện tử tối tân, cuối cùng bí mật công nghệ trị giá hàng nghìn tỷ của Samsung lại bị tuồn ra bằng hình thức truyền tin nguyên thủy nhất của loài người.

-

Bảy cú nhảy vọt công nghệ trong năm 2025 đẩy xe điện bước sang kỷ nguyên mới