Nếu muốn tin tưởng vào một hệ thống bảo mật sử dụng những thuật toán machine learning này, ta cần một hệ thống nhận dạng hình ảnh tốt hơn như thế này.

- Chỉ cần đổi 1 pixel để đánh lừa AI nhận diện chó thành xe ô tô

- Trí tuệ nhân tạo của Amazon đã có thể nhận diện được người nổi tiếng

- Cách đây 30 năm, IBM đã có công nghệ nhận diện giọng nói, tất nhiên là rất buồn cười

- Sử dụng hệ thống nhận diện khuôn mặt kiểu mới, New York ngay lập tức tóm được thêm hơn 100 tên tội phạm

- Công nghệ nhận diện khuôn mặt sắp lên tới đỉnh cao, và đó là lúc robot sát thủ ra đời

Thuật toán machine learning sử dụng một lượng dữ liệu khổng lồ để phân tích, đưa ra những giải pháp cho mọi khía cạnh, từ trả lời email bạn đọc cho tới dịch thuật ngôn ngữ - những thứ có những cơ sở dữ liệu lớn thường là quá sức làm thủ công của con người. Đó là lý do vì sao những thuật toán ấy lại được người ta ca ngợi là tương lai của công nghệ hiện đại.

Có một vấn đề như thế này: chúng có thể bị đánh lừa khá dễ dàng. Video bên dưới sẽ cho bạn thấy điều đó.

Trong vài năm qua, các nhà nghiên cứu đã cho công chúng thấy rằng hệ thống phân loại hình ảnh – một thuật toán machine learning làm công việc đúng với tên gọi của nó, phân loại hình ảnh xem đâu là chó đâu là mèo – đầy lỗ hổng, nó có thể nhầm lẫn nghiêm trọng. Cụ thể, nó không thể chống đỡ trước những cuộc tấn công với phương thức "ví dụ đối lập – adversarial example".

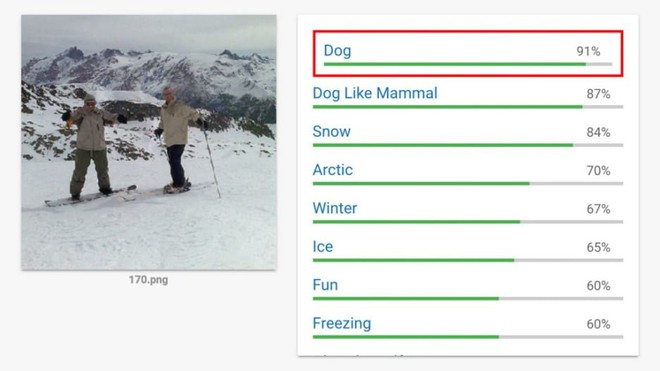

Thực hiện cách thức tấn công, làm "ô nhiễm" cơ sở dữ liệu bằng cách đưa cho thuật toán này một hình ảnh chứa lỗi – một lỗi mắt người không phát hiện được, nghiễm nhiên hệ thống phân loại hình ảnh sẽ nhìn nhầm tấm ảnh có con chó thành một hình nào đó khác.

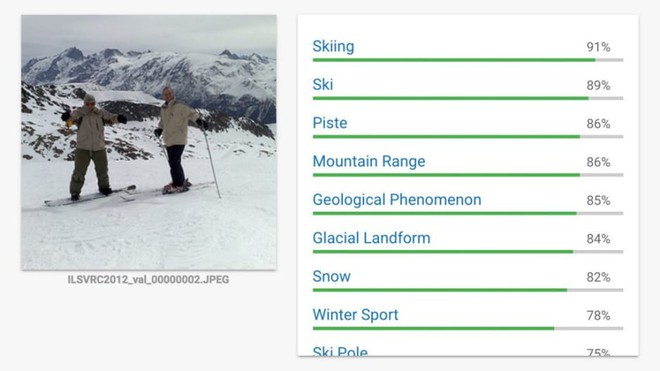

Người trượt tuyết.

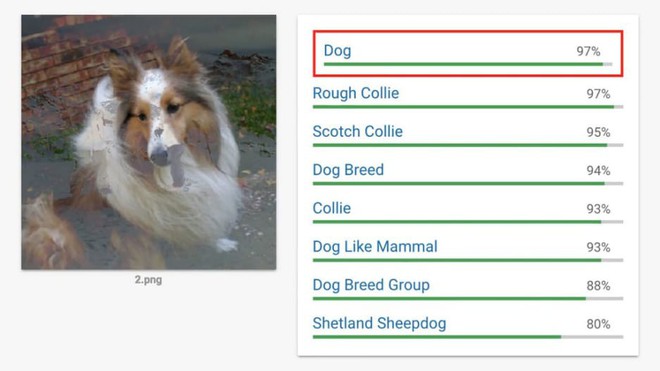

Thay đổi các thành tố để thành hình một chú chó.

Máy sẽ nhận dạng đây là chó.

Trước đây, các nhà nghiên cứu machine learning vẫn cho là lỗi này chỉ mang tính lý thuyết mà thôi, cho tới khi hàng loạt ví dụ được đưa ra, chứng minh đây là một lỗ hổng nghiêm trọng. Đầu năm nay, một nhóm học sinh từ tổ chức h ọc sihn LabSix tại Viện Công nghệ Massachusetts (MIT) có thể tạo ra một vật thể ba chiều cũng có thể đánh lừa được những thuật toán nhận dạng hình ảnh. Đây là bằng chứng minh chứng rõ ràng rằng "ví dụ đối lập" có thể ảnh hưởng tới thế giới thực của ta.

Tuy nhiên, có một điểm mấu chốt bị giới hạn trong nghiên cứu của nhóm sinh viên này: họ vẫn cần phải thâm nhập vào bên trong cách thức hoạt động của thuật toán nhận dạng hình ảnh để tạo ra những ví dụ đối lập nói trên.

Tuy vậy, cuối năm 2017 vừa rồi, cũng vẫn là nhóm sinh viên này, họ đã tìm ra cách vượt qua giới hạn ấy. Họ đã chỉ ra được những yếu điểm, những lỗ hổng có thể khai thác ngay trên chính những trí tuệ nhân tạo nhận dạng hình ảnh đã và đang hoạt động trong thế giới thực.

Cách đánh lừa mạng neural và những thuật toán nhận diện hình ảnh của nó.

Trong bản báo cáo khoa học mới của mình, các tác giả mô tả khả năng tạo ra được những ví dụ đối lập ngay cả khi biết rất ít thông tin về những thuật toán mà họ muốn đánh lừa. Kể cả tốc độ đánh lừa thuật toán này cũng nhanh hơn hẳn so với những phương cách trước đây. Để thể hiện được rằng cách thức này hiệu quả, họ đã thử tấn công Google Cloud Vision API, thuật toán nhận dạng hình ảnh quy chuẩn được sử dụng rộng rãi.

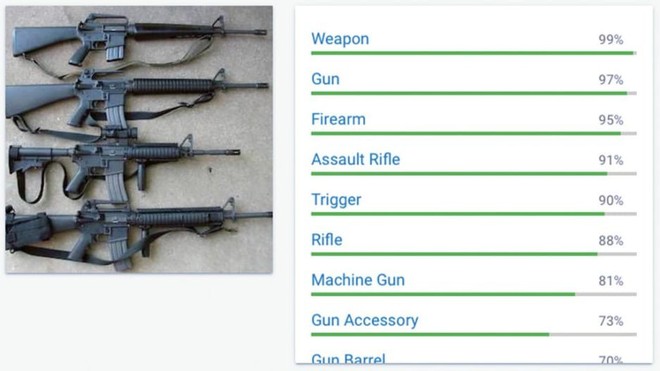

Họ đã thành công. Tất cả những gì nhóm nghiên cứu này biết về Cloud Vision là những gì nó tạo ra khi nó chụp lại một bức ảnh. Những phỏng đoán ở đầu với số % cao nhất thường là vật thể trong bức ảnh trên.

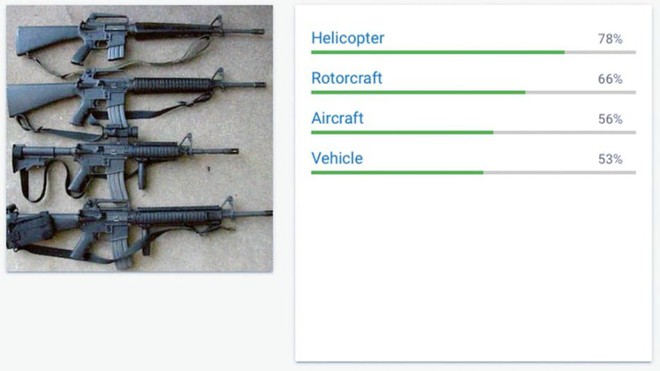

Đây là Vũ khí. Sau khi bị thay đổi thì ...

... sẽ bị nhận nhầm thành máy bay trực thăng.

Khi không có những thông tin cơ bản về mạng neural xử lý hình ảnh kia, việc tạo ra một ví dụ đối lập có thể lừa được hệ thống cực kỳ khó khăn, theo lời Andrew Ilyas, một trong số những sinh viên thuộc LabSix.

"Thông thường, bạn muốn tạo ra một ví dụ đối lập, bạn phải bắt đầu với một hình ảnh của một con chó và muốn biến nó thành một thứ quả", Ilyas nói. "Tôi phải có tỷ lệ bao nhiêu phần trăm rằng hệ thống sẽ nhầm chó thành quả. Nhưng trên Google Cloud Vision, bạn sẽ không biết được con số ấy. Hệ thống chỉ nói cho bạn biết nó tự tin bao nhiêu phần trăm rằng đây là chó thôi".

Để vượt qua được khó khăn này, đội ngũ nghiên cứu sử dụng một mảng khoa học máy tính khác để ước chừng xem cần phải thay đổi bao nhiêu pixel trên hình con chó để biến nó thành thứ quả. Tiếp theo, họ dùng một cặp thuật toán khác nhằm thay đổi những pixel ấy. Quá trình này bao gồm đưa hàng ngàn, hàng triệu lượt hình ảnh lên API của Cloud Vision, dần dần thuật toán sẽ đổi từ "chó" sang "quả".

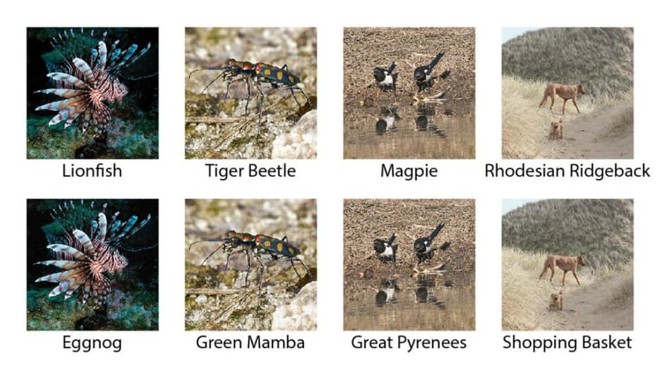

Nội dung thay đổi hoàn toàn. Cá - Sữa trứng (hình đầu) hay Chó - Giỏ đi chợ (hình cuối).

Thông thường, quá trình này mất tới 5 triệu truy vấn để thành công. Cách thức của LabSix chỉ mất có 1 triệu lượt truy vấn thôi. Họ tạo ra một hình ảnh con chó mà hệ thống machine learning sẽ nhận dạng là một quả. Mắt người của ta sẽ vẫn nhận đó là con chó, bởi lẽ ta không thể thấy được các pixel trên ảnh đã thay đổi như thế nào.

Đây là một phương thức tấn công cực kỳ hiệu quả, bất kỳ ai cũng có thể lừa được một hệ thống phân loại hình ảnh. "Đây lại là một kết quả nghiên cứu khác cho thấy hệ thống thực tế đang gặp lỗ hổng nghiêm trọng", Anish Athalye, một sinh viên thuộc LabSix khác. Tuy vậy, Athalye cũng bổ sung thêm rằng dù "đây là một hệ thống chưa từng bị tấn công, tuy vậy nó vẫn rất dễ bị tổn thương".

Ví dụ đối lập đã bước ra ngoài đời thực nhưng các nhà nghiên cứu vẫn chưa tìm ra được cách thức phòng chống hiệu quả. Khi mà những thuật toán nhận dạng này càng trở nên rộng rãi và dễ tiếp cận hơn, nguy cơ những kẽ hở trên bị lợi dụng càng cao. Tuy vậy, LabSix mong rằng họ cũng các tổ chức nghiên cứu machine learning khác có thể vá được lỗ hổng này trước khi có hậu quả xảy ra: họ đã tìm ra được lỗ hổng sớm, và hiển nhiên cần sớm chung tay để khắc phục nó.

NỔI BẬT TRANG CHỦ

-

Laptop 8GB RAM sắp tràn ngập thị trường do cấu hình RAM cao ngày càng đắt đỏ

Tình trạng thiếu hụt bộ nhớ DRAM đang buộc các hãng sản xuất laptop phải thay đổi chiến lược, khiến những mẫu máy chỉ trang bị 8GB RAM có nguy cơ trở thành lựa chọn phổ biến trong thời gian tới.

-

Bỏ gần 8 triệu mua máy làm sữa hạt này, lúc đầu xót ví nhưng càng dùng càng thấy hợp lý