Chiếc iPhone của bạn giờ đây có thể phân biệt được đâu là cái cốc và đâu là cái búa, bạn chỉ cần dạy nó thôi

Giáo trình dạy đã có chi tiết trong bài viết.

Điện thoại của bạn có biết phân biệt các đồ vật không?

Chắc chắn không, nhưng ta có thể dạy dỗ nó bằng một chút hiểu biết về code. Anh chàng lập trình viên Chris Greening kết nối camera iPhone của mình với CoreML, một nền tảng machine learning mã nguồn mở của Apple có thể sử dụng được với các sản phẩm của chính hãng này, bao gồm Camera và Siri và quan trọng nhất là Vision Kit, bộ nhận dạng khuôn mặt và khung cảnh của Apple.

Nhận dạng đồ vật bằng chính chiếc iPhone của bạn.

Trên blog của mình, Greening đã hướng dẫn từng bước thực hiện dự án này. Và nếu bạn muốn tự mình thử nó, bạn cần có một iPhone chạy iOS11 (Greening cảnh báo là iOS11 vẫn đang beta, đâm ra đừng thử nó với một cái điện thoại bạn dùng hàng ngày) và bên cạnh đó, bạn cần có phiên bản beta của xCode, có thể được tải về từ trang chủ của Apple. Toàn bộ quá trình code được Greening đăng tải trên Github.

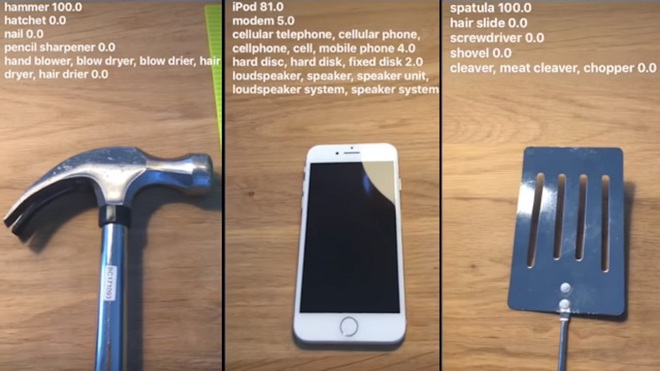

100% búa - 81% iPod - 100% xẻng lật thịt.

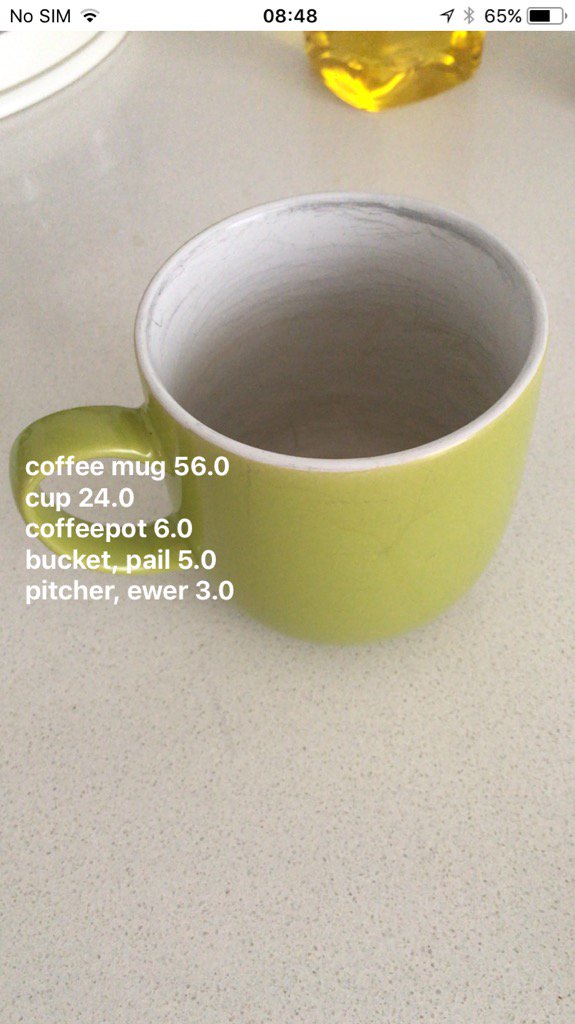

Nó nhận mặt được người anh em cùng họ hàng nhà Apple với nó, tuy nhiên chỉ đoán rằng 81% cái iPhone này là một cái iPod, còn lại là nó đoán chung chung đây là một cái điện thoại, một cái modem, v.v... Tuy nhiên, nó hoàn toàn đoán đúng cái bàn xẻng lật thịt, khá chắc chắn cái cốc là ... một loại cốc, một đồ vật gì đó để đựng nước.

56% cốc cà phê - 24% cốc - 6% bình cà phê - 5% xô đựng nước - 3% bình đựng nước

Một thiết bị đơn giản mà làm được thế là quá tuyệt vời rồi, tất nhiên là đơn giản khi so sánh với một hệ thống máy học có cả một server dữ liệu. Thử nghiệm này cho thấy công cụ Core ML của Apple cũng đáng để nghịch lắm đó chứ!

NỔI BẬT TRANG CHỦ

Google: Giải được bài toán 10 triệu tỷ tỷ năm chỉ trong 5 phút, chip lượng tử mới là bằng chứng về đa vũ trụ

Điều đáng ngạc nhiên hơn cả là nhiều người trên cộng đồng mạng thế giới lại đang đồng tình với kết luận của Google.

Gần 2025 rồi mà vẫn dùng USB để lưu công việc thì quả là lỗi thời