Nắm giữ vũ khí tối thượng của chiến trường AI, Nvidia ung dung hưởng lợi tỷ USD

Với vũ khí tối thượng này, các hãng công nghệ sẽ phải trả cho Nvidia hàng tỷ USD để tham gia cuộc đua AI.

Cùng với sự xuất hiện của ChatGPT, một cuộc đua AI mới giữa những người khổng lồ công nghệ toàn cầu đã bắt đầu khi lần lượt cả Microsoft và Google đều giới thiệu các chatbot AI riêng của mình. Bên cạnh đó đường đua này còn lôi cuốn cả các hãng nhỏ hơn tham gia như Stable Diffusion hay Runway với các sản phẩm có thể chỉnh sửa cả hình ảnh, video theo yêu cầu của người dùng.

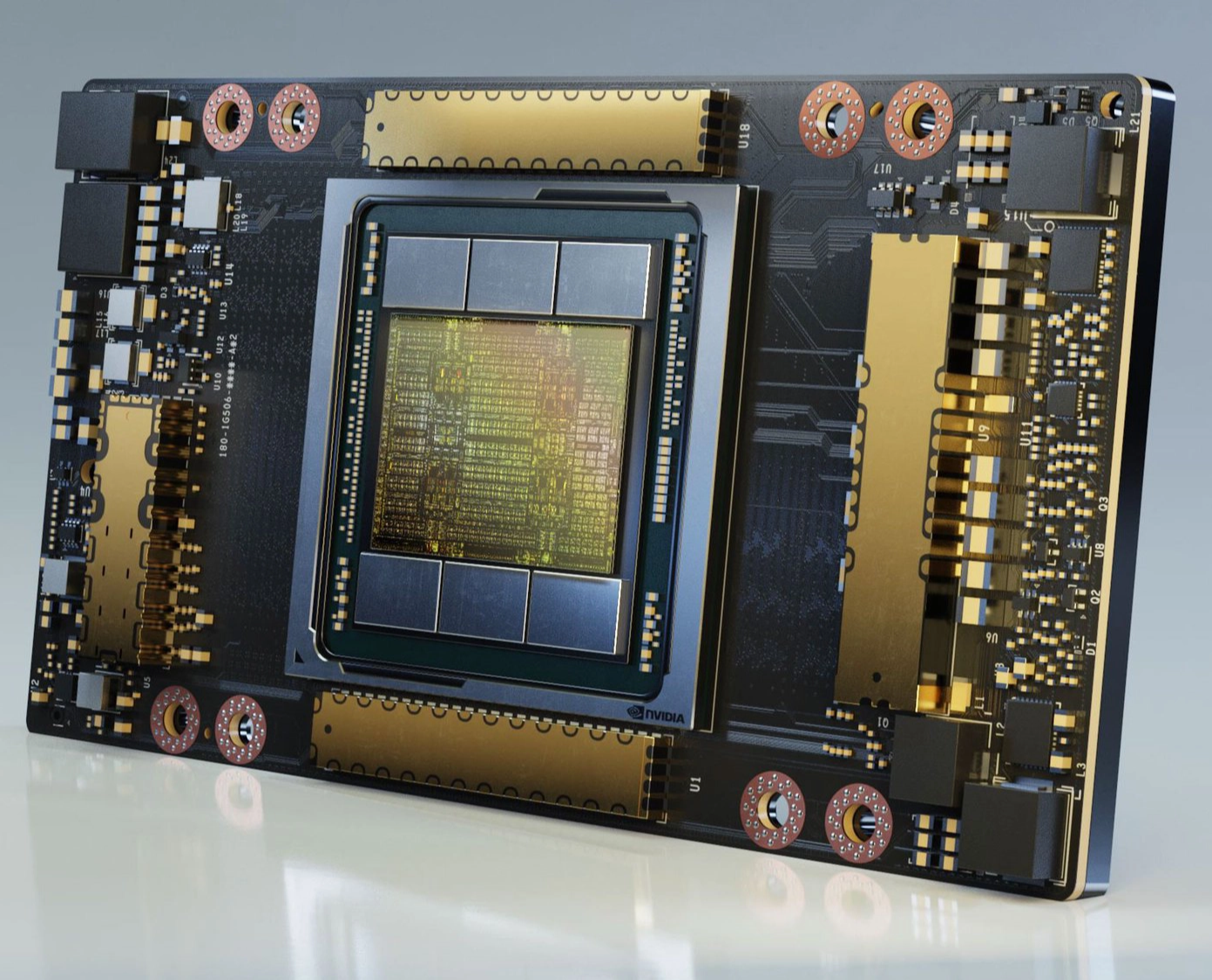

Bất chấp ai là người chiến thắng đi nữa, có một hãng vẫn đang ung dung "tọa sơn quan hổ đấu" và hưởng lợi từ cuộc đua này khi bán một trong những "vũ khí" lợi hại nhất của ngành công nghiệp AI cho tất cả các bên: các GPU Nvidia A100 có giá đến 10.000 USD mỗi sản phẩm.

Theo báo cáo của Nathan Benaich, một nhà đầu tư trong lĩnh vực AI, chip Nvidia A100 đang được xem như "ngựa thồ" không thể thiếu của lĩnh vực AI chuyên nghiệp hiện nay, cùng với đó là một danh sách các siêu máy tính đang sử dụng chip A100. Theo báo cáo của New Street Research, Nvidia đang chiếm đến 95% thị phần chip xử lý đồ họa dành cho học máy.

GPU A100 giá 10.000 USD của Nvidia. Ảnh Nvidia

Thiết kế và hiệu năng của Nvidia A100 khiến nó đặc biệt phù hợp với các mô hình học máy ngôn ngữ lớn hiện nay bên dưới các công cụ AI nổi tiếng hiện nay như ChatGPT, Bing AI và Stable Diffusion. Nó có thể thực hiện nhiều phép tính đơn giản cùng lúc – một điều rất quan trọng dành cho việc huấn luyện và sử dụng các mô hình mạng thần kinh nhân tạo.

Chính vì vậy, các công ty và các startup phát triển những phần mềm như chatbot AI hoặc các bộ sản sinh hình ảnh cần đến hàng trăm hay hàng nghìn con chip này. Trong khi những người khổng lồ công nghệ như Google hoặc Microsoft có thể tự mua chúng để trang bị cho mô hình của mình, các startup nhỏ hơn có thể tiếp cận nó thông qua các dịch vụ đám mây do những công ty trên cung cấp.

Đặc biệt các mô hình ngôn ngữ lớn phổ biến hiện nay phải dùng đến hàng trăm chip GPU này để huấn luyện những mô hình AI. Đó là vì những con chip này đủ mạnh để xử lý hàng terabyte dữ liệu giúp các cỗ máy nhanh chóng nhận ra mô hình cần thiết. Không chỉ vậy, các GPU như A100 còn cần thiết cho việc "suy luận" hay sử dụng mô hình AI để sản sinh văn bản, đưa ra dự đoán hoặc xác định các vật thể trong hình ảnh.

Google sẽ cần chi đến 80 tỷ USD để mua các GPU của Nvidia

Điều này có nghĩa các công ty sẽ cần ngày càng nhiều GPU Nvidia A100 hơn. Vào tháng Một vừa qua, CEO Stability AI – công ty đứng sau công cụ AI chỉnh sửa hình ảnh Stable Diffusion, Emad Mostaque cho biết trên Twitter: "Một năm trước, chúng tôi đã có 32 chip A100. Mơ lớn và lắp thêm nhiều GPU nữa." Cho đến hiện tại, Stability AI đang tiếp cận khoảng 5.400 GPU A100 - theo ước tính từ State of AI, một báo cáo theo dõi việc tiếp cận GPU A100 của các công ty và trường đại học.

Việc gia tăng đột biến số lượng GPU A100 cần dùng của Stability AI cũng cho thấy mức độ sử dụng dịch vụ của họ đã tăng lên như thế nào. Không chỉ để xây dựng mô hình AI, khi lượng truy cập của người dùng tăng lên, các công ty cũng cần tiếp cận nhiều GPU hơn để xử lý yêu cầu và cải thiện mô hình.

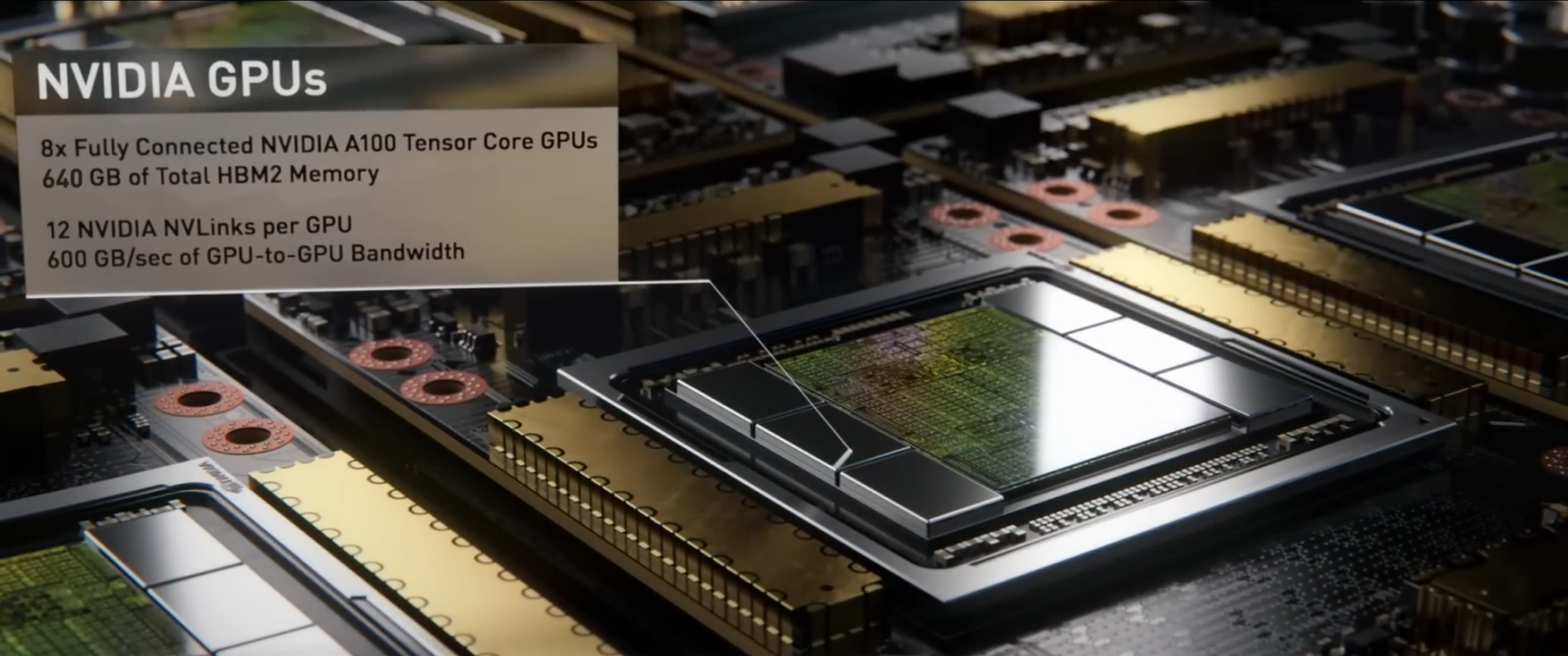

Hệ thống DGX A100 với 8 GPU A100 được ghép nối với nhau. Ảnh Nvidia

Bên cạnh các chip A100 đơn lẻ được gắn vào VGA để cắm vào các máy chủ hiện tại, nhiều trung tâm dữ liệu còn sử dụng một hệ thống của Nvidia chứa 8 GPU A100 được ghép nối với nhau, giúp gia tăng băng thông và tốc độ xử lý. Hệ thống này có tên DGX A100, được Nvidia cung cấp với giá 200.000 USD mỗi bộ.

Một ước tính của New Street Research cho thấy, mô hình ChatGPT của OpenAI trong công cụ tìm kiếm Bing cần 8 GPU để đưa ra một phản hồi cho mỗi câu hỏi trong vòng một giây. Vì vậy, Microsoft có thể phải cần đến 20.000 máy chủ chứa 8 GPS đó chỉ để triển khai Bing đến mọi người dùng hiện tại. Nghĩa là Microsoft có thể phải chi đến 4 tỷ USD cho cơ sở hạ tầng máy chủ của mô hình AI này. Thế nhưng con số này có thể chưa là gì so với Google.

Cấu hình của hệ thống DGX A100. Ảnh Nvidia.

Antoine Chkaiban, nhà phân tích công nghệ tại New Street Research cho biết: "Nếu bạn mở rộng quy mô sang số người dùng của Google, hiện phục vụ từ 8 đến 9 tỷ truy vấn mỗi ngày, bạn sẽ phải chi đến 80 tỷ USD cho các hệ thống DGX."

Theo thông tin đăng tải do hãng Stability AI đăng tải, phiên bản mới nhất trong bộ chuyển đổi hình ảnh Stable Diffusion của họ đã được huấn luyện trên 256 GPU A100, hay 32 cỗ máy chứa 8 GPU A100, trong tổng cộng 200.000 giờ tính toán. CEO Stability AI, Mostaque cho biết, tính theo giá thị trường, riêng việc huấn luyện mô hình này đã tiêu tốn 600.000 USD – được xem như rẻ bất thường so với các đối thủ khác – dù chưa tính đến chi phí suy luận hoặc triển khai mô hình.

Hệ thống DGX-A100 được ông Jensen Huang giới thiệu tại nhà vào năm 2020 khi phải cách ly do Covid-19. Ảnh Internet

CEO Nvidia, Jensen Huang cho biết trong một cuộc phỏng vấn với CNBC rằng, các sản phẩm của công ty thực ra khá rẻ so với khối lượng tính toán mà nó mang lại: "Chúng tôi cho rằng phải cần đến 1 tỷ USD để xây dựng được một trung tâm dữ liệu bằng CPU, và chúng tôi thu gọn nó xuống thành một trung tâm dữ liệu 100 triệu USD. Giờ 100 triệu USD đó, bạn đưa lên mây và chia sẻ cho 100 công ty, nó gần như chẳng là gì cả."

Lợi thế từ GPU A100 biến cuộc đua mô hình AI trở thành mảnh đất béo bở cho Nvidia và trở thành hãng hưởng lợi trực tiếp từ chiến trường này. Cho dù AMD và Intel đều đang phát triển các bộ xử lý đồ họa và Google cũng như Amazon đều có các chip chuyên dụng được thiết kế cho xử lý AI, nhưng điều đó không ảnh hưởng nhiều đến vị thế của Nvidia.

Theo báo cáo của State of AI, phần cứng AI vẫn phụ thuộc mạnh mẽ vào Nvidia. Theo báo cáo này, tính đến tháng 12 năm 2022, hơn 21.000 tài liệu AI mã nguồn mở cho biết đang sử dụng chip của Nvidia cho nghiên cứu của mình.

Tham khảo CNBC

NỔI BẬT TRANG CHỦ

-

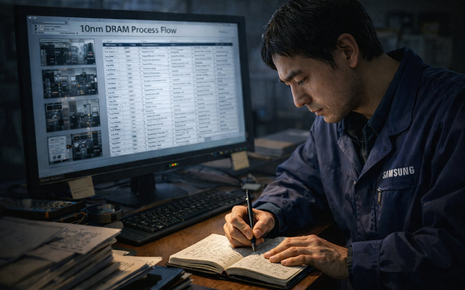

Không USB, không email, làm thế nào nhân viên Samsung tuồn quy trình 600 bước của công nghệ DRAM 10nm sang Trung Quốc?

Dù được bảo vệ nghiêm ngặt bằng nhiều thiết bị giám sát điện tử tối tân, cuối cùng bí mật công nghệ trị giá hàng nghìn tỷ của Samsung lại bị tuồn ra bằng hình thức truyền tin nguyên thủy nhất của loài người.

-

Bảy cú nhảy vọt công nghệ trong năm 2025 đẩy xe điện bước sang kỷ nguyên mới